Voir rapport en 2023.

Il s’est écoulé plusieurs années avant que je me décide à documenter un sujet qui, pourtant, concerne notre santé, notre style de vie et notre « vivre ensemble »… La survie de l’espèce humaine serait même menacée : « Nous roulons sur une autoroute qui mène à un enfer climatique, avec un pied sur l’accélérateur », déclarait Antonio Guterres, le Secrétaire général de l’ONU, à l’ouverture de la COP 27, le 7 novembre 2022.

Longtemps, je m’étais contenté de garder sous le coude des articles, des liens vers des blogs, ainsi qu’une pile d’ouvrages accusés de « climato-scepticisme ». C’est de cette littérature qu’il est question ici, dédouanée de toute forme de dissonance cognitiveN1. Les écrits sérieux et documentés se prêtent à un examen critique, dédramatisé, du discours sur le climat.

Quelles sont donc les vraies causes du changement climatique ? Soyons clair : je vais parler des causes, et non des conséquences…

Pour un accès immédiat à des documents qui font débat, suivre les liens de la section Pétitions et déclarations.

Avertissement : toute prise de parole sur « le climat » s’expose à une tentative de disqualification entendue des centaines de fois dans les débats francophones : « Mais vous n’êtes pas climatologue ! » Je me demande si les auteurs de tels commentaires savent en quoi consiste le métier de climatologue… Le physicien François Gervais ouvre quelques pistes (Moranne JM, 2024aA184 p. 4) :

Le mot-clé « climatologie » est l’un des 55 qui définissent le champ d’application des enseignements et des recherches dans le cadre de la section 23 Géographie physique, humaine, économique et régionale du Conseil National des Universités. Autant les universités savent définir, pour éventuellement le recruter, les compétences d’un mathématicien, d’un physicien, d’un chimiste, d’un biologiste, d’un géographe, autant la climatologie apparaît-elle ainsi à sa vraie place, une sous-discipline de la Géographie parmi 54 autres. Combien d’auteurs des rapports du GIEC, le Groupe d’Experts (traduction un peu pompeuse du titre anglais “Panel”) Intergouvernemental sur l’Évolution du Climat, justifient-ils d’une thèse en climatologie ?

Mais, après tout, c’est sans importance : quand des journalistes, des politiciens ou des militants (souvent très jeunes) relaient avec autorité un message sur la « crise climatique », personne ne s’autorise à les questionner sur leur culture scientifique et technique. En tout cas, pas moi.

Les arguments d’autoritéN2 servent à court-circuiter tout débat avec les réfractaires à une doctrine, exposée avec passion, qui s’impose à la manière d’un embrigadement. Chacun accuse le camp opposé de « complotisme », un autre verrou de l’esprit critique.

Le terme « embrigadement » peut choquer. Mais je le crois approprié, certainement dans la continuité du « Nous sommes en guerre » proclamé par le Président Macron en mars 2020, au début de la crise sanitaire causée par la circulation du virus SARS-CoV‑2. Car, si l’on doit faire face à une crise climatique, il est légitime de se mobiliser pour entrer en rébellion…

Documenter le discours sur le climat m’est apparu bien plus difficile que suivre au jour le jour la « crise sanitaire » — voir mon article Coronavirus — discussion. Ce sujet est plus vaste, plus technique, plus étendu historiquement, et potentiellement porteur d’enjeux sur le très long terme. Malheureusement, trop de journalistes se contentent de surfer sur l’immédiat, empruntant les éléments de langage aux porte-voix de « La Science », à l’occasion d’événements météorologiques extrêmes annoncés presque chaque jour depuis l’été 2023…

Le discours sur le climat a envahi le champ du politique sous une forme qui ne tient compte, ni de la complexité des données, ni des incertitudes des « modèles climatiques ». On pourrait le résumer, au mieux, en trois mots : « objectif zéro carbone »… Les adversaires de ce camp « climato-alarmiste », qui brandissent surtout des arguments économiques (voir plus bas), ont tendance à rejeter en bloc toute mesure environnementale. Cette polarisation du débat fait passer au second plan — si ce n’est aux oubliettes — les risques avérés et quantifiables de l’activité humaine. Pour en citer quelques-uns, en vrac : production de substances toxiques, mauvais recyclage des déchets, dégradation des sols agricoles, pollution de l’eau, perte de biodiversité, disparition des pollinisateurs et de la faune marine, bétonisation des espaces urbains…

Les articles et ouvrages qui ont retenu mon attention ne sont pas de simples « billets d’humeur ». Les opinions des experts — que leurs détracteurs accusent d’être « autoproclamés » — ne m’intéressent pas. Pour la plupart, ce sont de médiocres extraits, interprétés et extrapolés de manière invérifiable, de Résumés pour les décideurs (SPM) des rapports du GIEC (Gervais F, 2022A94 p. 145).

L’absence de sources scientifiques, dans les articles de presse, exclut toute analyse critique : après tout, aux yeux de Gabrielle Maréchaux, le « climatoscepticisme » n’est rien d’autre qu’un banal jeu de séduction (2024A166) ! Quant à la lecture intégrale d’un rapport du GIEC — 2408 pages pour l’AR6 du Groupe 1 (2021N3) —, elle exigerait beaucoup de temps, et surtout de solides compétences dans l’intégralité des domaines couverts par la littérature scientifique dont il présente une synthèse. Mes informateurs, pour la plupart issus des « sciences dures », n’ont pas peur de manipuler des équations différentielles… Je n’irai pas aussi loin !

Je me suis intéressé à des ouvrages ou des articles dont les contenus sont étayés par des liens vers des sources primaires — autrement dit, des publications de revues scientifiques à comité de lecture. Exit Wikipedia et son culte des données secondaires, comme expliqué dans ma présentation…

Surprise agréable : les pages de nombreux sites climato-réalistes sont ouvertes aux commentaires. On apprend parfois plus en les lisant que dans les articles qui les ont motivés… Après tout, « faire de la science » c’est, entre autres, dialoguer avec celles et ceux qui expriment des avis divergents, pourvu qu’ils s’appuient sur des données vérifiables.

J’invite les lecteurs de cette page à faire de même : suivre les liens, consulter les articles, dialoguer avec leurs auteurs, lire (en entier) quelques-uns des ouvrages cités, pour revenir s’exprimer en public dans les commentaires.

Greta Thunberg nous supplie : « Écoutez les scientifiques ! » (2019A286). Eh bien, c’est précisément ce que nous allons faire…

La suite de cet article n’est pas transcrite oralement. Il n’est pas possible d’aborder ce sujet sans avoir sous les yeux le texte, les images, et les liens vers les sources !

Sommaire

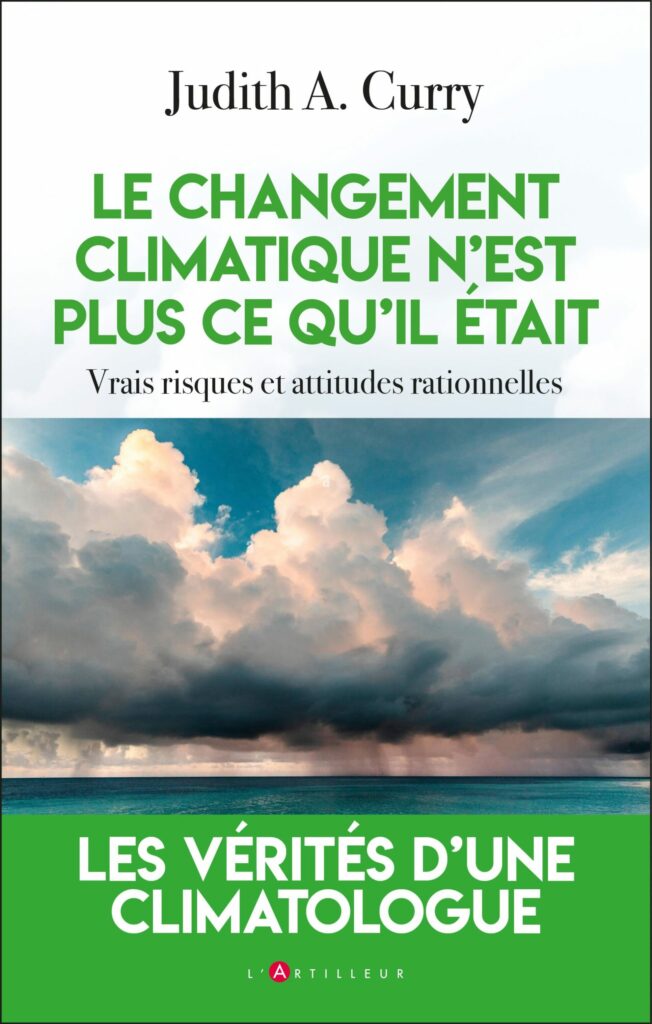

Ajouter (Moranne JM, 2024bA185 ; Curry JA, 2024A52 ; May A, 2020A173) et plus de 300 références citées au bas de cette page…

Malgré mon aversion pour les vidéos, j’ai placé dans ce texte de nombreux liens positionnés vers des passages de films de Martin Durkin (2007A67 ; 2024A68). Ceci afin de montrer quelques images des auteurs cités — par exemple John Clauser (2024A68 06:03). Toutefois, j’en ai détesté les premières minutes qui invitent à une lecture troublée par les émotions, et pour finir une critique caricaturale du militantisme écologique (voir ci-dessous).

Autres vidéos intéressantes, les émissions « complotistes » Corruption Climatique (Citizen Light, 2025aA41 ; 2025bA42) où se sont exprimés Jean-Marc Bonnamy, Drieu Godefridi, Daniel Husson, Rémy Prud’homme, Camille Veyres et Michel Vieillefosse. Toutefois, la diversité des opinions insuffisamment étayées — en raison du format « table ronde » — nuit un peu à la cohérence du discours.

⇪ Le GIEC et Al Gore, Prix Nobel 2007

En 1988 a été fondé le Groupe d’experts intergouvernemental sur l’évolution du climat (GIEC). Le contexte historique et politique de cette fondation est exposé plus bas.

Le terme anglais Intergovernmental Panel on Climate Change (IPCC) ne contient pas le mot « expert », qui en français peut prêter à confusion. En effet, cet organisme ne dirige pas des travaux scientifiques. Il est chargé de documenter et synthétiser toute la littérature ayant trait au changement climatique.

À l’origine, le document “Principles Governing IPCC Work” précisait que le GIEC (IPCC) avait pour mission d’étudier le risque du changement climatique causé par l’activité humaine. La mention de ce lien de causalité a disparu par la suite, une fois établi « par consensus » que l’activité humaine — comprenez, les « gaz à effet de serre » — était la principale cause du réchauffement de la Planète. Nous verrons plus bas quelle est la réalité de ce consensus.

Le lien de causalité est clairement énoncé dans l’article premier de la Convention-cadre des Nations unies sur les changements climatiques (1992A201 p. 5) :

On entend par « changements climatiques » des changements de climat qui sont attribués directement ou indirectement à une activité humaine altérant la composition de l’atmosphère mondiale et qui viennent s’ajouter à la variabilité naturelle du climat observée au cours de périodes comparables.

Autrement dit, sans l’activité humaine, il n’y aurait pas de changement climatique. Guillaume de Rouville commente de manière imagée (2024A57 p. 31, 34) :

Avant l’homme, il y avait le climat, sans changement(s). Un climat sage et obéissant aux constantes de l’univers, se balançant comme le pendule d’une horloge bien rythmée entre des bornes naturelles acceptables pour les Dieux, les plantes et les animaux de la Terre. Un équilibre primordial. Puis vint l’homme, et le climat sortit de ses limites naturelles pour entraîner avec lui le balancier (originellement) tempéré dans une course folle le précipitant vers les enfers anthropiques d’un dérèglement sans fin. […]

En quelques phrases et deux articles, des juristes et technocrates internationaux ont ainsi réussi à tuer définitivement la science climatique et à imposer une théorie axiomatique du climat qui ne laisse guère de place à la recherche, à la controverse et au débat contradictoire. Les « experts » et « scientifiques » du climat du monde entier ont été mis (ou se sont mis volontairement) au service d’une norme juridique dont l’aspect normatif l’emporte sur les frontières ouvertes de la science.

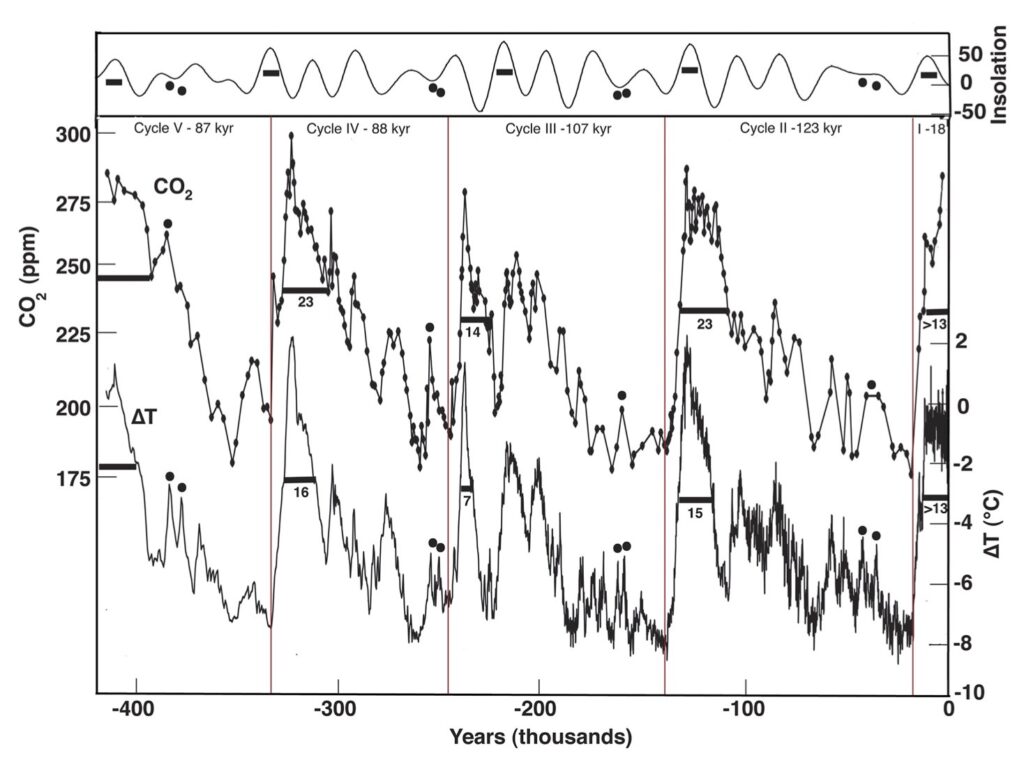

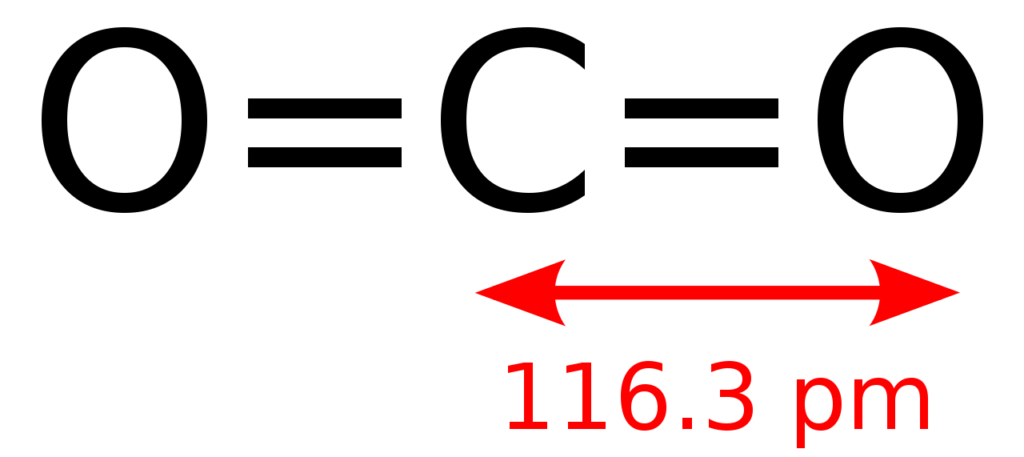

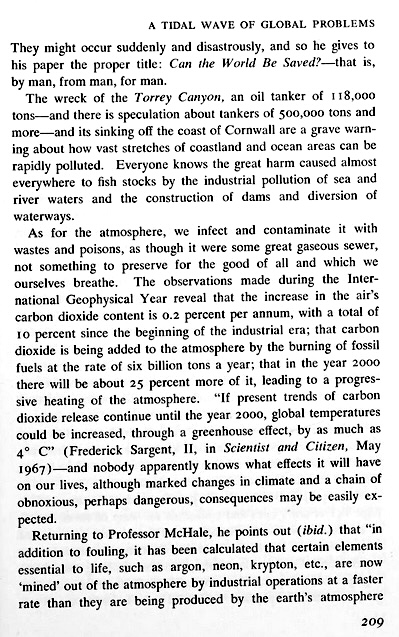

La thèse alarmiste du « CO2 qui réchauffe la planète par effet de serre » a été postulée, à la fin des années 1960, par des personnes en vue comme comme Aurelio Peccei, fondateur du Club de Rome, dans la lignée du rédacteur en chef du journal Science, Philip Hauge Abelson (1967A2). Ils reconnaissaient Svante August Arrhenius (1896A11), prix Nobel de Chimie en 1903, comme un précurseur de cette théorie, bien que l’inexactitude de ses propositions ait été démontrée par ses pairs (Poyet P, 2022A221 p. 32–34). Le terme (inapproprié) « effet de serre » a été utilisé en premier par Nils Gustaf Ekholm (1901A73).

Sur cette page, on utilise « CO2 » pour désigner le gaz carbonique que les chimistes écrivent « CO2 ». Cette simplification est passée dans l’usage.

À la même époque que Peccei, des auteurs comme Carroll E Wilson et William Matthews avaient attribué la variation du climat à des causes naturelles, ou à l’influence humaine, avec une réserve pour ce qui est du rôle du gaz carbonique (1971A315 p. 112) :

Pour déterminer l’effet d’une augmentation de la concentration de CO2 sur la température de surface, il faut d’abord démontrer que les changements de CO2 affecteront le bilan radiatif dans le système terre-atmosphère. Ensuite, s’il n’y a pas d’autres ajustements simultanés ou couplés dans d’autres variables que celles de l’équilibre (telles que la teneur en eau de l’atmosphère, la nébulosité ou la couverture neigeuse) en raison du changement de l’équilibre radiatif qui pourrait être causé par l’augmentation du CO2, l’effet des changements de CO2 sur la température atmosphérique moyenne globale à l’équilibre pourrait être prédit par ce modèle.

Lire The Birth of the Environmental Movement (Poyet P, 2022A221 p. 402–412) pour plus de détails historiques sur la mise en place des politiques environnementales. Dans son ouvrage Politics and Climate Change, a History (2020A173), Andy May donne une quantité d’informations cruciales sur les acteurs institutionnels dans le monde anglophone.

En 2010, les gouvernements sont tombés d’accord sur la nécessité de réduire leurs émissions de gaz à effet de serre afin que le réchauffement planétaire soit inférieur à 2 °C à la fin du siècle. Ce seuil a été réévalué à 1.5 °C selon l’Accord de Paris à la COP 21 (2015).

La climatologue Judith A Curry a écrit à ce sujet (2024A52 p. 39–40, 461–462 ; 2023A51 p. 10–11, 297) :

La validité scientifique de cet objectif de 2 °C a été contestée. Carlo Jaeger, spécialiste du développement durable, a décrit la façon dont cette limite a été définie de façon ad hoc et contradictoire — les décideurs politiques la considérant comme une découverte scientifique et les scientifiques comme une approche politique. Elle a été présentée comme un seuil séparant le domaine de la sécurité de celui de la catastrophe, et une stratégie optimale du juste équilibre entre les coûts et les bénéfices [Jaeger C & J Jaeger, 2010A123]. […]

Aucun seuil (ou point de basculement) à grande échelle du climat n’a été clairement lié à un réchauffement planétaire de 2 °C. Le réchauffement planétaire moyen n’est pas le seul changement climatique potentiellement dangereux, et les gaz à effet de serre comme le CO2 ne sont pas la seule cause d’un changement climatique dangereux. Certains seuils potentiels ne peuvent être liés significativement au changement de température planétaire, étant d’une nature plus régionale, d’autres sont surtout sensibles aux gradients spatiaux du changement de température. […]

Il y a encore quelques années, une trajectoire d’émissions conforme au RCP 4.5, avec un réchauffement de 2 à 3 °C, était considéré comme une réussite de la politique climatique. Comme limiter le réchauffement à 2 °C semble faisable (maintenant présenté comme le « seuil de la catastrophe »), l’objectif a été revu en 2018 — il s’agit désormais de limiter le réchauffement à 1.5 °C [Masson-Delmotte V, 2018A168].

Un récit incisif a fait l’objet du chapitre 6 de L’imposture climatique (Allègre C, 2010A9 p. 163–218). Ouvrage de 294 pages, grand prix de la Société de géographie en 2010, mais qui, selon certains commentateurs — sans plus de précisions — contiendrait « plus d’une centaine d’erreurs scientifiques graves » ! Merci de me les signaler… ?

Le GIEC regroupe (en 2023) 195 États dont les représentants ont un droit de vote identique. Son mode de fonctionnement fait apparaître les décisions comme autant de consensus dans l’interprétation d’articles scientifiques sélectionnés par des groupes d’experts.

Le terme « consensus » s’est imposé dans le discours sur ce qui a été appelé, successivement, « réchauffement climatique », « changement climatique », puis « dérèglement climatique », « crise climatique », enfin « urgence climatique » et même « effondrement climatique »… Cette dérive du vocabulaire est le reflet d’une croyance de plus en plus infaillible en l’effet sur le climat des activités humaines : industrie, agriculture, transports, chauffage urbain, nutrition, etc. Une issue apocalyptique que les humains ont le pouvoir (et le devoir) de contrecarrer en luttant avec acharnement contre le réchauffement climatique.

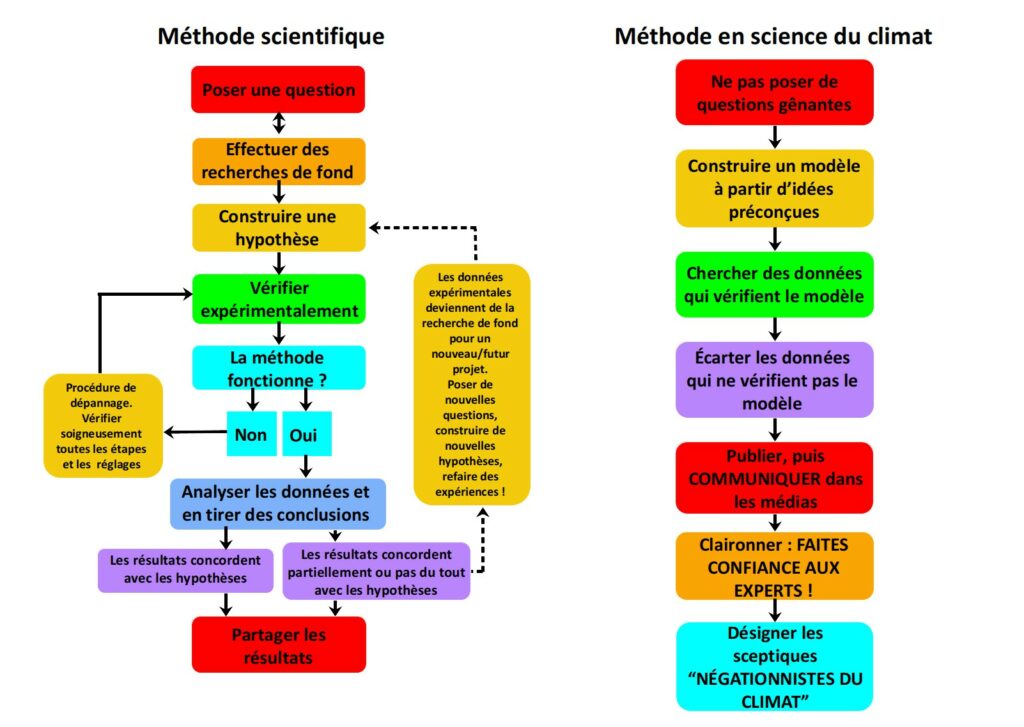

Aux yeux du public — et des décideurs politiques, appuyés par les médias — le consensus est un gage de vérité, bien qu’il se situe aux antipodes d’une démarche scientifique, laquelle consiste à soumettre toute hypothèse à l’épreuve du réel. Cet examen procède d’une réflexion critique, examinant avec une attention particulière les faits qui paraissent contredire l’hypothèse.

Le mythe d’un consensus de « 97.1 % de scientifiques » (Cook et al., 2013A47) a été clairement démonté par David R Legates et ses collègues (2015A149). Il est fréquemment recyclé, avec la même comptabilité puérile, par exemple par Mark Lynas et al. (2021A161) qui parviennent à 99 % : les auteurs ont mis dans le consensus en faveur de l’origine humaine du réchauffement climatique les 70 à 80 % d’articles qui pourtant ne parlaient pas d’une origine humaine du réchauffement climatique, ou qui ne parlaient même pas de réchauffement climatique. Autrement dit, tous ceux qui ne sont pas « contre » sont nécessairement « pour » ! Sans surprise, le même pseudo-raisonnement appliqué avec le biais inverse — « contre » par défaut — aboutit au résultat inverse…

Cette recherche de consensus a poussé le GIEC à privilégier les « scénarios de climat » produits par les modèles mathématiques des climatologues, balayant du revers du coude leurs détracteurs et ses propres contradictions (Masson H, 2019A169) :

En inférence statistique, quand après un calcul de courbe de régression, les résidus ne sont pas constants et négligeables, on conclut que le modèle est imparfait et l’on change de modèle. Le GIEC, lui, interprète la non-constance des anomalies de température en clamant que c’est le système climatique qui dérive, tout en gardant une confiance aveugle dans ses modèles.

Claude Allègre écrivait (2010A9 p. 182) :

[…] à partir de là, les choses vont s’accélérer. Avec une méthode qui ne va jamais se modifier et fera ses preuves : le consensus entre les membres d’un petit groupe d’initiés, d’un côté ; la disqualification, l’opprobre, puis l’exclusion de ceux qui sont tenus pour des déviants parce qu’ils émettent — osent émettre ! — une opinion divergente. C’est la pratique de l’ostracisme grec, celle qui a poussé Thémistocle à devenir l’allié des Perses. Ce qui veut dire que, hors du groupe restreint, le débat est interdit.

L’ouvrage Impasses Climatiques (Gervais F, 2022A94) expose clairement les dysfonctionnements du GIEC qui révèlent une approche pseudoscientifique du sujet. L’auteur, physicien, avait été accrédité par le GIEC comme expert reviewer des deux plus récents rapports AR5 (en 2013) et AR6 (en 2021) dont il avait signalé — sans être entendu — les erreurs et contradictions (2022A94 p. 145–158). Depuis cette « mutinerie », François Gervais est catalogué « climatodénialiste » et « complotiste » (cf. Wikipedia) alors que ce professeur émérite à l’Université de Tours a dirigé un laboratoire du CNRS (UMR 6157). Ancien conseiller scientifique du Pôle de compétitivité Sciences et Systèmes de l’Énergie Électrique, il est médaillé du CNRS en thermodynamique et lauréat du prix Ivan Peyches de l’Académie de sciences. Excusez du peu !

Un autre personnage dérangeant, récemment mis sur la touche, est l’un des trois lauréats du Prix Nobel de physique en 2022, John Clauser. Il préside la CO2 coalitionN4. Lire à son sujet un article de Mattias Desmet, ainsi que la traduction d’une conférence à L’Irish Climate Science Forum, le 8 mai 2024, titrée : Le thermostat des nuages est le mécanisme dominant de contrôle du climat qui stabilise le climat de la Terre ; le récit catastrophique du GIEC est un mythe (Clauser J, 2024A45, voir vidéo).

En 2007, le prix Nobel de la paix avait été conjointement attribué au GIEC et à l’ancien vice-président des États-Unis d’Amérique, Al Gore (Albert Arnold Gore), suite à la diffusion de son film An Inconvenient Truth (2007A4) (Une vérité qui dérange). Ce documentaire alertait de manière spectaculaire sur les effets dramatiques du réchauffement de la Planète causé par l’activité humaine. Selon cette « vérité », le changement climatique serait attribué principalement à l’effet de gaz à effet de serre, savamment décrit comme un forçage radiatifN5.

Le film d’Al Gore était construit sur, au minimum, neuf affirmations mensongères (Moranne JM, 2024bA185 p. 33–35) dont il sera question plus bas dans cet article. Par exemple, des images montraient Manhattan submergé sous six mètres d’eau… Les films de Martin Durkin (2007A67 18:40) et de Simon Clark (2023A44) peuvent être vus comme des réponses à celui d’Al Gore.

Claude Allègre rappelle la suite (2010A9 p. 74) :

Pour le reste, il n’est pas sans intérêt de savoir qu’Al Gore a été condamné par la Haute Cour de Londres et le juge Burton pour diffusion de fausses preuves scientifiques, et qu’en conséquence le film d’Al Gore n’a pas pu être projeté en Grande-Bretagne dans les écoles sans un avertissement préalable identifiant neuf erreurs (décision de janvier 2007). La presse française n’a pas fait état, sur le coup, de cette mise en garde, ce qui en dit long. De nombreux journaux n’ont appris la nouvelle, semble-t-il, que beaucoup plus tard, la relayant lorsqu’Al Gore et son film avaient disparu de l’actualité.

Q : Pour le commun des mortels, n’est-il pas singulier qu’on donne un prix Nobel — certes pas un prix Nobel scientifique — à un homme qui a fait un film en utilisant, à vous suivre, des arguments faux ?

C’est le sentiment de beaucoup de scientifiques, consternés par le choix des Nobel. M. Jouzel a, en revanche, affirmé, lui, que le film était excellent et que ce qu’il montrait était vrai.

On peut rire des prédictions farfelues d’Al Gore — qui a récidivé en 2017 avec Une suite qui dérange (2017A5) — et de la naïveté de son public, mais la France aussi a eu, au sommet de l’État, des clowns tristes de l’alarmisme climatique : le 28 septembre 2015, le Président François Hollande avait osé dire, à la 70e session de l’Assemblée Générale des Nations-Unies, que les tsunamis et les tremblements de terre étaient un effet du réchauffement climatique (Hollande F, 2015A116) !

L’année 2007 était aussi celle du rapport AR4N6 du GIEC, dont les erreurs ont par la suite été reconnues publiquement (Gervais F, 2022A94 page 146) :

Répété à l’envi par le président du GIEC et par le secrétaire général des Nations Unies, l’AR4 a affirmé que le réchauffement climatique pourrait réduire la production agricole africaine de 50 % d’ici 2020. Le problème est qu’il n’y avait aucune preuve à l’appui de cette affirmation. Le GIEC avait simplement réitéré une affirmation douteuse issue, non d’un article publié dans une revue internationale à comité de lecture, mais d’une brochure publiée par une ONG. Le responsable du groupe de travail du GIEC a été contraint d’admettre en 2010 que l’affirmation n’était nullement étayée.

Le dioxyde de carbone (CO2) était seul dans le viseur. Par chance (pour les technocrates), le bilan carboneN7 de toute activité humaine peut être calculé, puis inscrit dans le circuit économique sous la forme de taxes carboneN8 et de quotas d’émissionN9. Ce n’est pas le cas, par contre, du protoxyde d’azote N2ON10 jugé 298 fois plus « polluant » que le CO2, et dont une source importante, bien que non mesurable en quantité, serait la culture du riz sous inondations intermittentesN11 (Kritee K et al., 2018A143).

⇪ Histoire d’eau

Enfin et surtout, les calculs cités par le GIEC faisaient abstraction de l’eau, sous forme de vapeur et de nuages, principal gaz à effet de serre (Lindzen R, 2018A153 p. 5). François Gervais écrit à ce sujet (2022A94 p. 79–80) :

Après une nuit sous une couverture nuageuse, la température matinale reste proche de celle de la veille au soir. En revanche, après une nuit sans nuages, elle est généralement beaucoup plus fraîche que celle de la veille au soir. L’écart d’énergie associé à ces changements de température est considérable, beaucoup plus que la contribution raisonnablement attribuable aux émissions de CO2. C’est le cycle de l’eau et ses composantes vapeur et nuages qui régulent le climat de la Terre. Un changement de la couverture nuageuse ou de la distribution de types de nuages, ou de la proportion de vapeur d’eau, est capable de contrebalancer l’effet du CO2 comme l’ont montré Dübal et Vahrenholt (2021A70).

Ces mécanismes ont été exposés en détail par Henrik Svensmark et Eigil Friis-Christensen (1997A278), ainsi que Patrice Poyet (2022A221 p. 124–127) qui écrit :

On pourrait même dire que le climat est déterminé par la quantité de pluie reçue, mois après mois, par n’importe quelle région de la Terre, et ni la théorie CAGW [catastrophic anthropogenic global warming] ni les modèles de circulation généraleN12 (GCM) associés ne sont bons pour faire des prévisions à cet égard (Koutsoyiannis, 2008A139). Le régime spatial et temporel des précipitations est une conséquence de l’organisation de la circulation atmosphérique, dont le « but » est le transfert de la vapeur d’eau des zones tropicales vers les hautes latitudes où elle se condense et alimente le rayonnement de l’air vers le cosmos dans l’infrarouge thermique (OLR, Outgoing Long-wave Radiation), de manière à compenser exactement, « en moyenne » sur l’ensemble du globe et sur quelques semaines, le flux solaire absorbé par le globe.

La vapeur d’eau, qui se précipite sous forme de pluie ou de neige, ne provient souvent pas de l’endroit où il pleut ; elle provient du balayage par les alizés de milliers de kilomètres vers le nord et vers le sud : ces alizés convergent dans la « cheminée équatoriale » ; pour les averses des fronts froids de nos latitudes, la vapeur d’eau vient de milliers de kilomètres au sud-ouest, et elle est transférée vers le nord-est dans le couloir dépressionnaire qui précède les Anticyclones Mobiles Polaires (AMPA297) qui se déplacent, eux, vers le sud-est.

Veyres (2020a p. 157, 62) conclut « que les histoires de “forçage radiatif par les gaz-à-effet-de-serre” sont des inepties et que c’est la teneur en vapeur d’eau de la haute troposphèreN13, et non pas un réchauffement de cette haute troposphère qui détermine et régule le flux infrarouge thermique émis par le globe vers le cosmos. […] Rappelons une fois encore que c’est la quantité de vapeur d’eau autour de 9 km qui assure en quelques heures et quelques jours la régulation du rayonnement du globe vers le cosmos, et qu’il est absurde et contraire aux observations de poser a priori qu’elle va croissant. » Par ailleurs, l’effet régulateur de la vapeur d’eau n’a été correctement évalué par aucun des modèles. La plupart de ses effets sont dus à son opacité dans les régions spectrales des ondes longues. Les contributions relatives de H2O, CO2 et O3 à la réduction du flux sortant d’ondes longues sont très différentes, et l’effet de H2O sur les ondes longues est tellement plus important que les effets de CO2 et O3 qu’il ne laisse aucune chance à d’autres gaz de jouer un rôle réel.

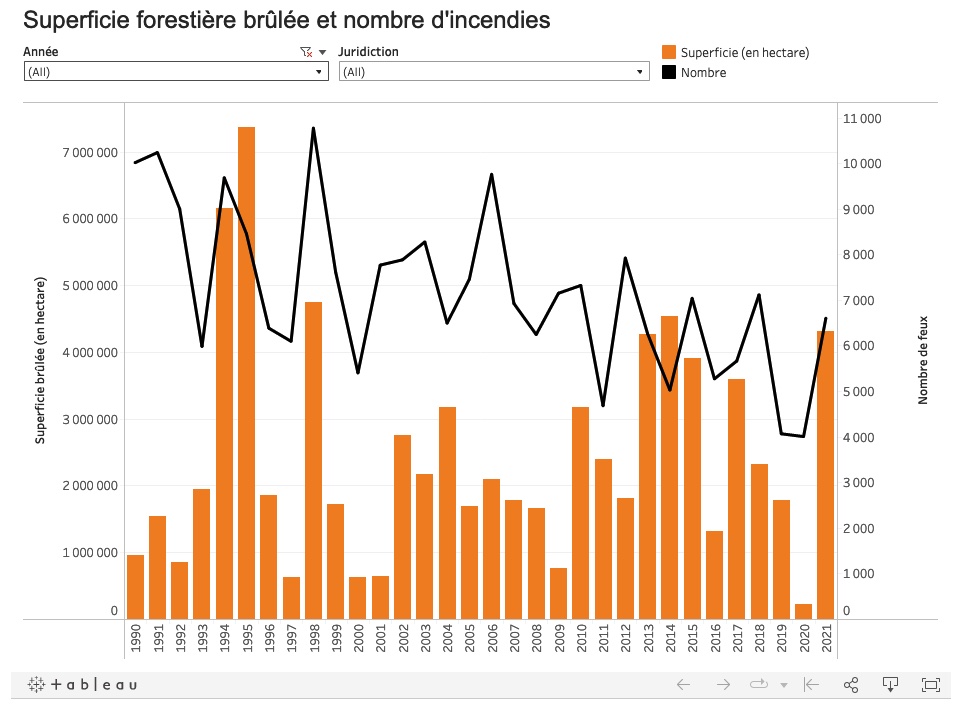

Les mesures de l’humidité atmosphérique dans les régions arides ou semi-arides sont aussi en contradiction avec ce que prédisent les modèles de climat (Simpson IR et al., 2024A264) :

La vapeur d’eau dans l’atmosphère devrait augmenter avec le réchauffement, car une atmosphère plus chaude peut contenir plus d’humidité. Cependant, au cours des quatre dernières décennies, la vapeur d’eau près de la surface n’a pas augmenté dans les régions arides et semi-arides. Cela va à l’encontre de toutes les simulations de modèles climatiques dans lesquelles elle augmente à un rythme proche des attentes théoriques, même dans les régions sèches. Cela pourrait indiquer que les modèles représentent mal les processus liés à l’hydroclimat ; les modèles augmentent la vapeur d’eau pour satisfaire la demande atmosphérique accrue, alors que cela ne s’est pas produit dans la réalité. Étant donné les liens étroits entre la vapeur d’eau et les incendies de forêt, le fonctionnement des écosystèmes et les températures extrêmes, cette question doit être résolue afin de fournir des projections climatiques plus fiables pour les régions arides et semi-arides du monde.

Dans un atelier Nouveaux outils statistiques en hydrologie, lors d’un symposium sur la gestion des ressources en eau, Demetris Koutsoyiannis déclarait (2008A139) :

La recherche hydrologique a apporté des contributions décisives en matière de stochastique (Hurst, Mandelbrot, Hosking), alors que les climatologues utilisent encore des représentations stochastiques simplistes et irréalistes. […]

Traditionnellement, les hydrologues possèdent des compétences qui sont peut-être moins répandues dans la communauté climatologique :

• Le pragmatisme, lié à la formation d’ingénieur ;

• L’expertise dans l’aide à la prise de décision en situation d’incertitude ;

• Une familiarité avec les prévisions à long terme (pour la conception de grands travaux), et en particulier l’impossibilité d’utiliser des approches déterministes pour les réaliser. […]

Un changement de paradigme est nécessaire dans le domaine du climat :

• Des termes et définitions ambigus aux concepts clairs ;

• Des certitudes fallacieuses à la reconnaissance de l’incertitude ;

• Des approches déterministes aux approches stochastiques.

Deux articles de Brigitte Van Vliet-Lanoë et Jean Van Vliet (2022aA296 ; 2022bA297) dressent un bilan de l’influence sur la météo et le climat de phénomènes très importants — pour la plupart non modélisables sur le long terme et sans lien significatif avec l’activité humaine : circulation thermohalineN14 des océans (thermal conveyor belt), irradiance solaire, jet streamsN15, vent solaire, etc. Conclusion en quelques mots :

L’évolution météorologique est une image à très court terme du système climatique : elle n’a de valeur que si on l’intègre dans un contexte au minimum décennal. Madame Soleil (F) et Monsieur Météo (B) ne peuvent pas prédire l’évolution du climat. Encore moins les médias.

Un séminaire de travail sur l’évolution du climat, à l’Académie des sciences, avait accueilli l’intervention de Marcel Leroux sur le thème Les échanges méridiens commandent les changements climatiques (2007A151).

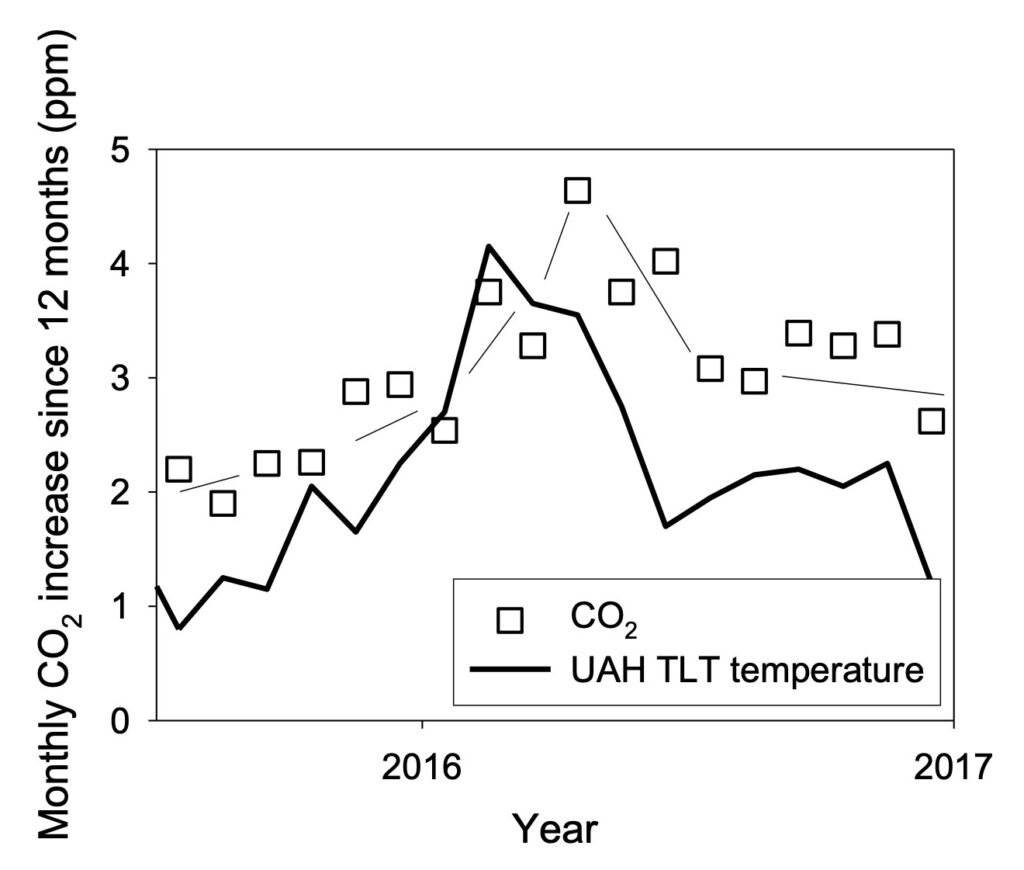

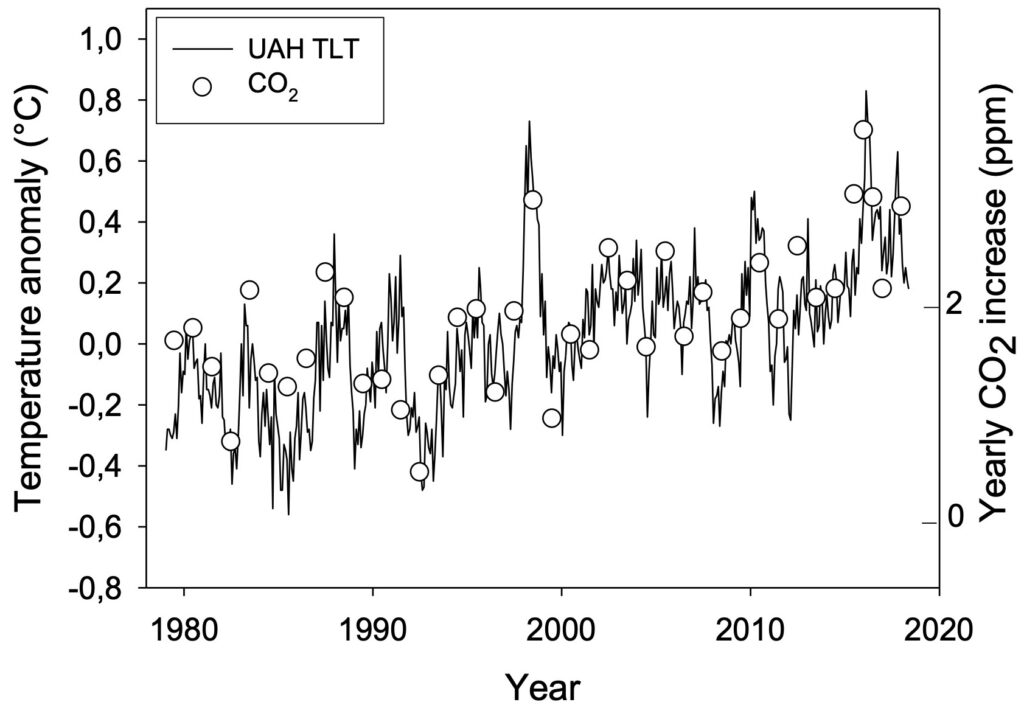

Les perturbations dans la circulation atmosphérique El NiñoN16 et La NiñaN17 échappent aux modèles prédictifs, bien qu’elles aient une influence considérable sur les variations saisonnières de température. El Niño provoque un échauffement, alors que La Niña provoque un refroidissement, mais avec des effets qui peuvent être radicalement différents selon les parties du globe, par exemple une sécheresse au Sahel en même temps que des pluies diluviennes au Brésil (Troude M, 2024A291). Il est courant d’entendre les climatologues admettre qu’ils sont un des principaux vecteurs du changement climatique, tout en ajoutant (sans l’ombre d’une preuve) que ces phénomènes sont « aggravés » par la production de gaz à effet de serre…

⇪ Représentation des données

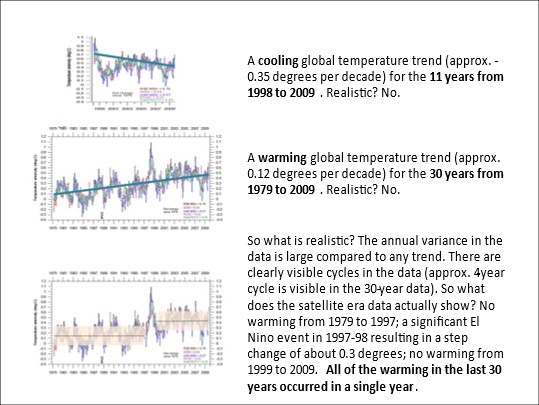

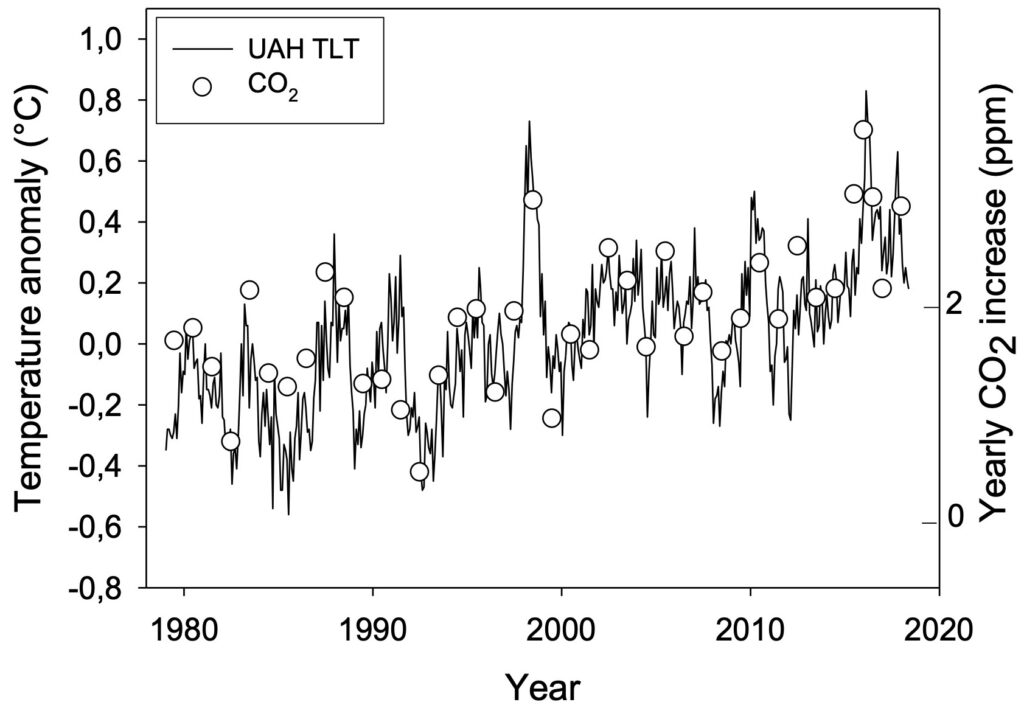

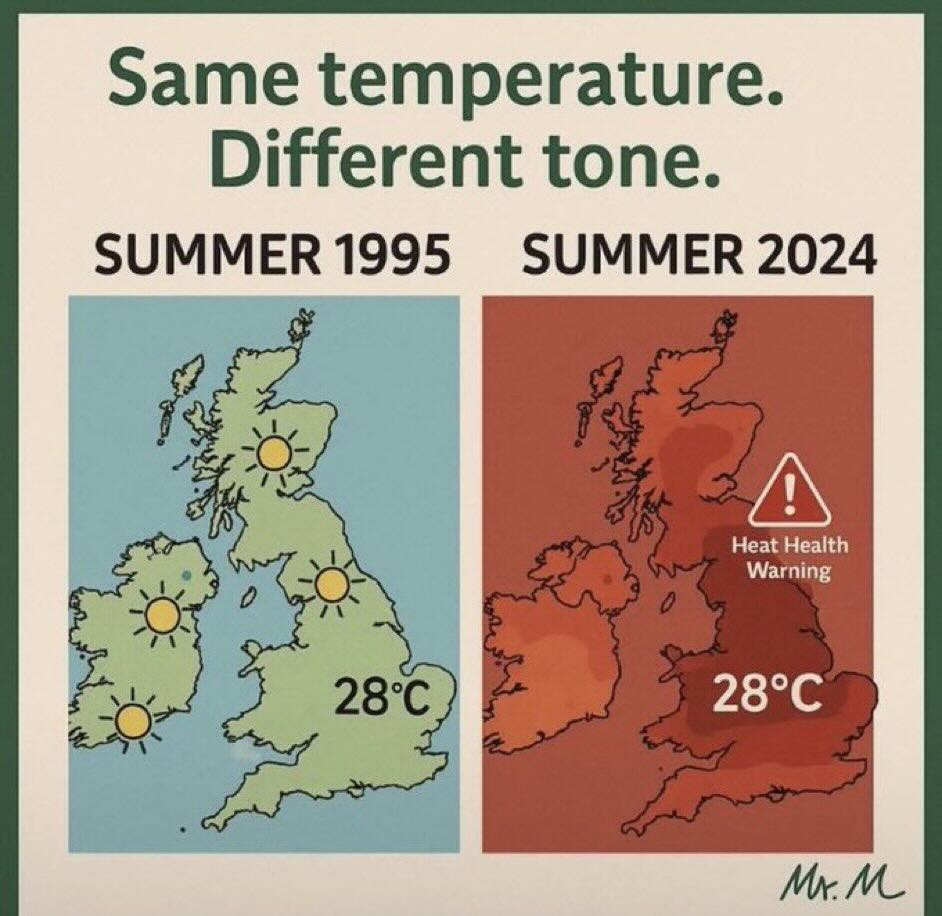

Une première faiblesse du discours alarmiste sur le climat réside dans l’interprétation arbitraire, voire tendancieuse, de données statistiques, s’appuyant sur des modes de représentation simplistes.

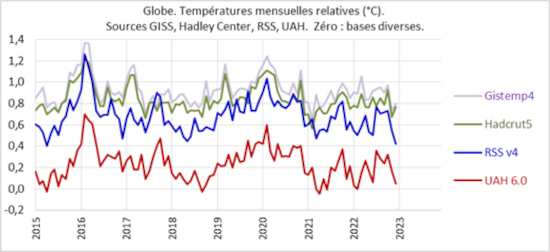

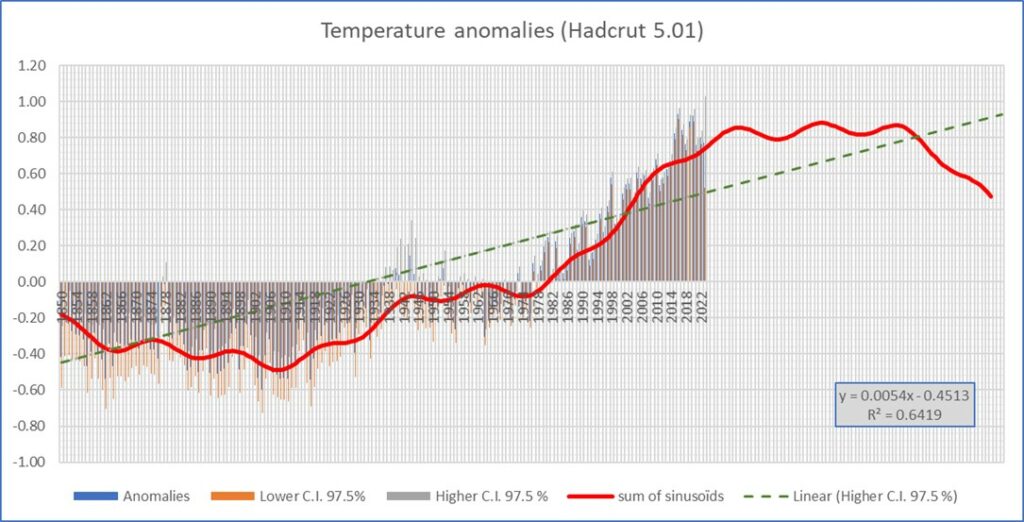

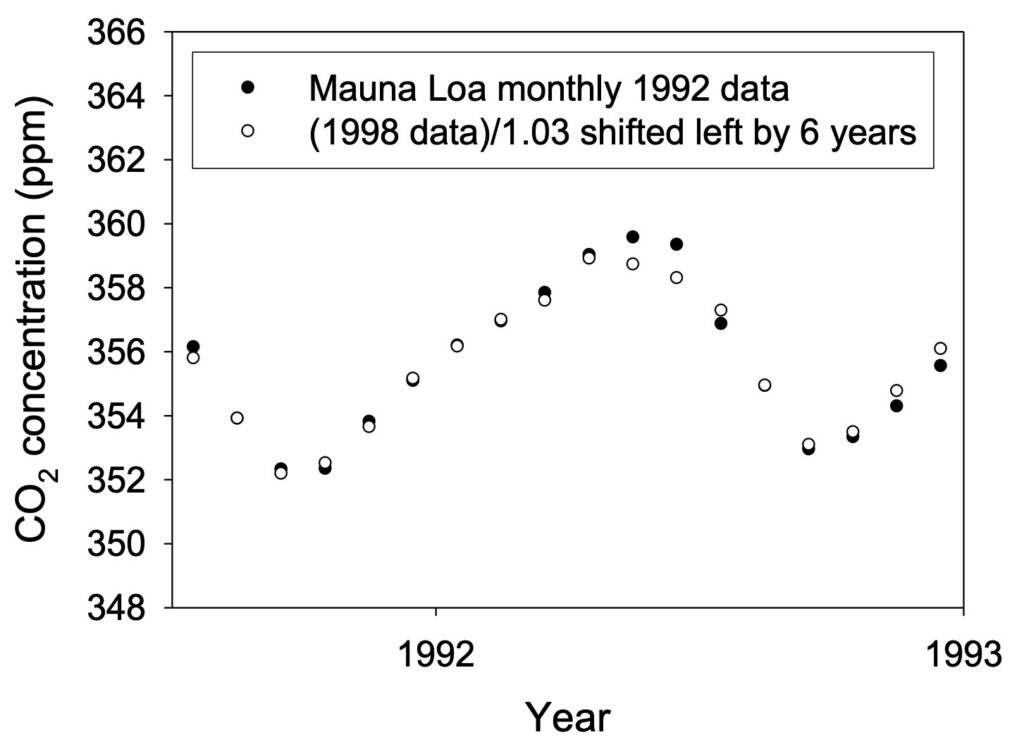

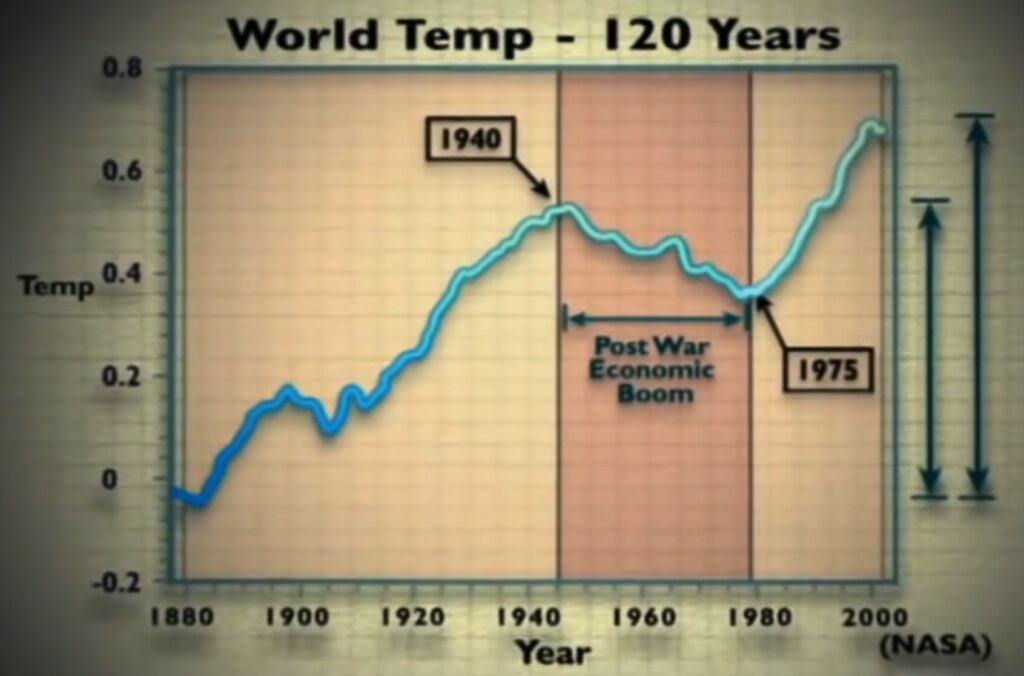

Henri Masson (2023A170), par exemple, critique la méthode qui consiste à réduire une série temporelle de mesures à des droites de régression. Le simple choix de l’intervalle temporel permet d’en modifier la pente, et donc la signification en termes d’augmentation ou de diminution. Sur l’image ci-dessus, la régression linéaire des températures de 1979 à 2009 fait apparaître un réchauffement global alors que, de 1998 à 2009, on assisterait à un refroidissement. En divisant l’intervalle en deux sections, on peut faire apparaître une absence de variation entre 1979 et 1997, ainsi qu’entre 1999 et 2009, avec un saut de 0.3 degrés en 1997–1998, résultat d’un événement El NiñoN16. Aucune de ces trois représentations n’est réaliste…

Une méthode plus saine d’analyse d’une série temporelle consiste à rechercher en premier lieu des composantes périodiques en faisant appel à la transformée de Fourier de la fonction d’autocorrélation (Masson H, 2023A170 figure 28). Dans l’exemple considéré, quatre composantes présentent une magnitude supérieure à la composante continue (fréquence zéro) qui est de 0.15° C. On peut donc réduire la série à une somme de quatre sinusoïdes et une composante continue : la courbe en rouge ci-dessous. La prolongation de cette courbe suggère un passage par un maximum proche de 0.8°C, qui serait suivi d’un refroidissement.

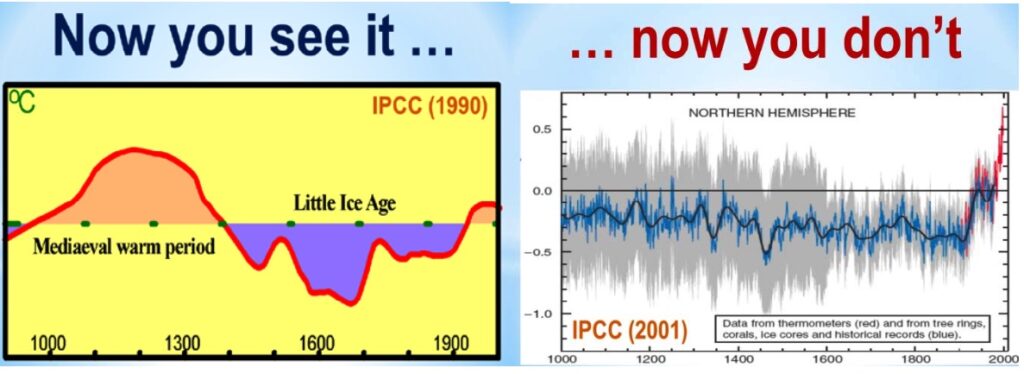

Une mauvaise farce pour ceux qui affirment qu’il suffit de prolonger (linéairement) les observations pour prédire la continuation, ou même une accélération du réchauffement ! Voir à ce sujet le graphique en crosse de hockey de Michael E Mann (1998N18) dont la méthodologie erronée a été signalée par la suite (McIntyre S & R McKitrick, 2003A175, 2005A176 ; Duran J, 2013A66 ; Deheuvels P, 2024A59). Un récit détaillé des procès qui ont eu lieu à la suite et autour de la publication de Mann est donné dans le chapitre 5 (Lawsuits and Climate Change) de l’ouvrage d’Andy May (2020A173 p. 164–198).

Michael Mann s’était entre autres appuyé sur un historique des températures basé sur la mesure des épaisseurs des anneaux de croissance des arbres. Håkan Grudd (2008A102), de son côté, a révélé que l’augmentation d’épaisseur des jeunes anneaux des arbres était un effet de la compaction des anneaux plus anciens, et non la trace d’un réchauffement que Mann aurait donc surévalué. D’autres critiques portent sur le fait que l’article de Gordon Jacoby et Rosanne d’Arrigo (1989A122) ne portait que sur une sélection de dix sites fournissant « le meilleur enregistrement dans le temps et dans l’espace de la croissance des arbres influencée par la température pour cette région de l’Amérique du Nord » (p. 44) alors que 36 avaient été échantillonnés. Les relevés des 26 sites écartés de l’étude n’ont pas été archivés, malgré la demande insistante des éditeurs (McIntyre S, 2023A178).

En l’absence de modèle, l’hypothèse empirique proposée par Masson (courbe en rouge ci-dessus) serait envisageable, et certainement plus que celle d’une droite de régression (en pointillés verts), car le coefficient de déterminationN19 est de 0.907 pour les sinusoïdes et seulement 0.647 pour la droite.

La courbe rouge est en réalité proche de celle de l’Oscillation atlantique multidécennale (AMON20), une variation de la température de surface de la mer sur un cycle d’environ 65 à 70 ans (Schlesinger ME & N Ramankutty, 1994A252). François Gervais écrit à ce sujet (2022A94 p. 109) :

Le refroidissement de la Terre observé de 1945 à 1975 […] a principalement concerné l’hémisphère nord, comme le montrent de nombreuses études […]. L’AMO est justement observée dans l’Atlantique Nord, et l’oscillation était en phase de refroidissement durant cette période. Elle n’est pas la seule. La comparaison avec l’Oscillation [multidécennale du] Pacifique (PDON21) est confondante, dans la mesure où une phase froide est également observée de 1947 à 1976 (figure 2.10).

Plus globalement, les indices AMO et PDO apparaissent synchrones avec la série de températures HadCRUT4N22. Tous trois confirment une phase montante récente. Si ces cycles se poursuivent, ils devraient être suivis par une phase descendante dans les quelque trente ans à venir.

Judith Curry écrit (2024A52 p. 192–193 ; 2023A51 p. 116) :

La plupart des analyses ont identifié l’Oscillation atlantique multidécennale (AMO) comme jouant un rôle déterminant sur la température de la planète. On a estimé son impact sur les températures moyennes de surface de 0.3 à 0.4 °C [Chylek P et al., 2016A40]. Le climat est dans la phase chaude de l’AMO depuis 1995 ; en 2021, vingt-six ans s’étaient donc écoulés depuis le dernier basculement. L’analyse des données historiques et paléoclimatiques suggère que le retour à la phase froide devrait se produire dans les douze prochaines années (vers 2032), avec une probabilité de 50 % qu’il survienne dès les cinq prochaines années (vers 2026 [Enfield DB, 2006A75]).

François Gervais (2022A94 p. 110–111) :

Scafetta (2021aA247) [voir traduction 2021bA248] identifie plusieurs cycles supplémentaires d’amplitudes toutefois moindres. Il montre surtout, par une analyse de Fourier, que le cycle d’environ 60 ans et les autres sont remarquablement corrélés à la vitesse du soleil par rapport au centre de masse du système solaire (Scafetta N, 2009A244). Le cycle principal d’environ 60 ans implique les deux planètes les plus massives, Jupiter et Saturne, selon que leurs orbites respectives autour du soleil les amènent ou non proches, avec des conséquences gravitationnelles sur la boule de gaz déformable qu’est notre étoile, qui s’ajoutent si elles sont proches, ou non. Scafetta et al. (2020A251) considèrent toutefois d’autres explications possibles à ces observations, toutes plus naturelles les unes que les autres, du moins sans aucun lien avec les émissions de CO2.

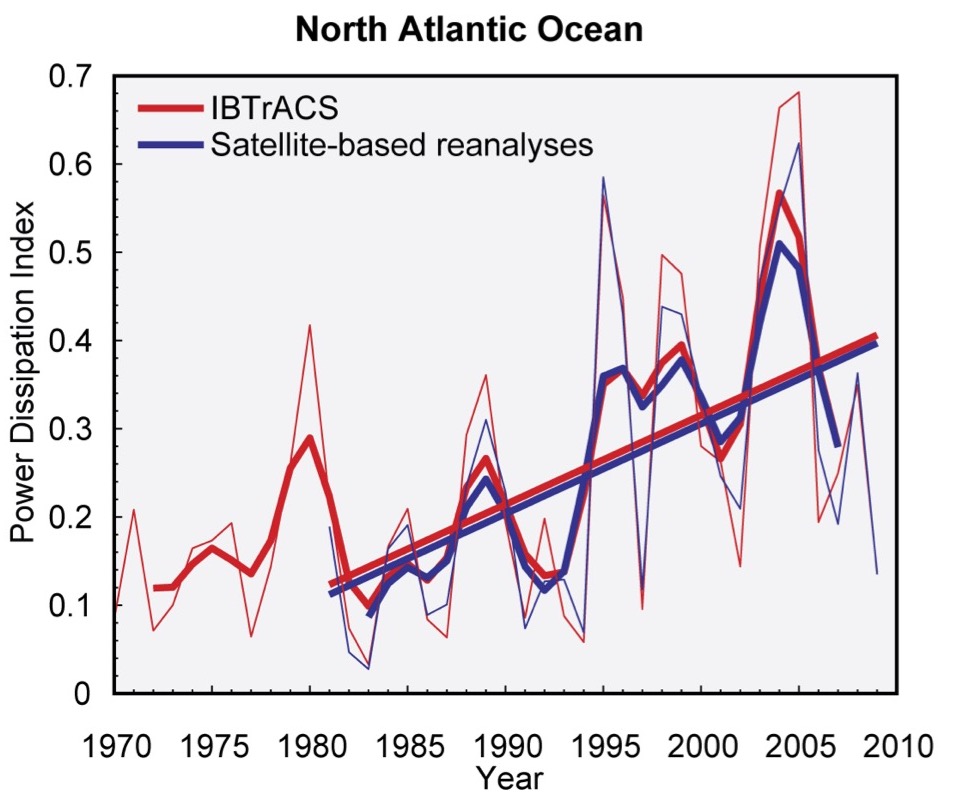

La réduction d’une série temporelle à une droite de régression dans le sens souhaité — en choisissant pour cela les dates de début et de fin — révèle un tel amateurisme qu’on est en droit de douter que des « experts du climat » y aient recours. Or cette manipulation des données a été utilisée pour représenter l’indice de puissance dissipée par les ouragans dans l’Atlantique Nord, de 1981 à 2005. Ceci afin d’étayer, dans les rapports de la science du climat aux États-Unis (CSSR, 2014N23 p. 20), la prédiction d’un accroissement du nombre et l’intensité des ouragans en Atlantique Nord (Koonin SE, 2021A135 p. 116–121). Cette prédiction n’était pas celle, entre autres, de James B Eisner et collègues (2006A74 page 92).

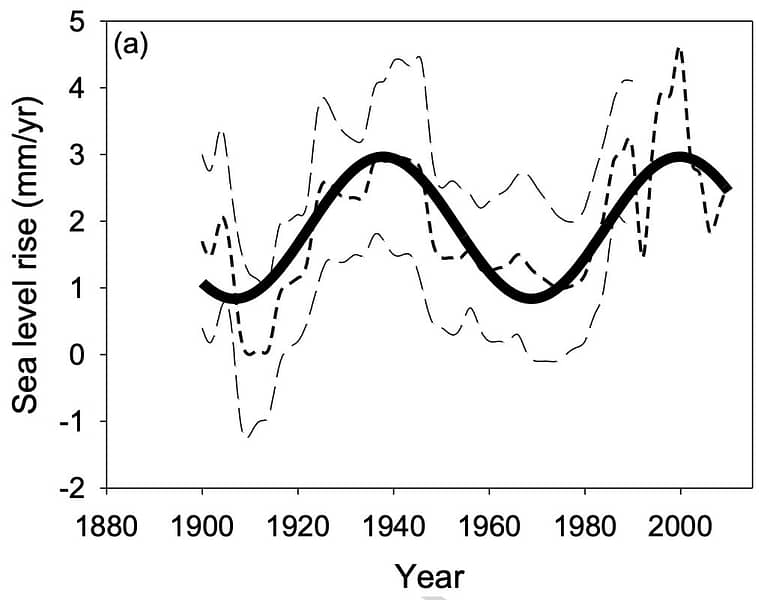

Un autre exemple de régression sinusoïdale faisant apparaître une périodicité a été présenté par François Gervais (2016A91). La figure ci-contre représente l’évolution de l’incertitude sur les valeurs supérieures et inférieures de la hausse du niveau des océans rapportées par les marégraphes, selon la figure 3.14 du rapport AR5 (2013) du GIEC. La courbe en trait gras est une régression par une sinusoïde de période 62 ans. Elle fait apparaître, sur la période 1900 à 2000, une hausse annuelle moyenne variant entre 1 et 3 millimètres.

Cette oscillation a été confirmée par Thomas Frederikse et al. (2020A85), rapportant toutefois une hausse moyenne de 1.52 ± 0.33 mm par an de 1900 à 2018, donc plus faible que la moyenne de la figure de Gervais qui était basée sur seulement 240 marégraphes (2022A94 p. 118).

Un exemple d’interprétation tendancieuse des données — pour parler vrai, une fraude scientifique — était la « reconstruction » des températures du deuxième millénaire dans le troisième rapport du GIEC (2001). L’explication suivante a été fournie par Christopher Walter (2013A308 p. 8) :

Source : Christopher Walter, Viscount Monckton of Brenchley (2013A308 p. 8)

L’article The Frozen Climate Views of the IPCC . An analysis of AR6 révèle comment les mentions de la période chaude médiévale et du petit âge glaciaire ont de nouveau été effacées lors des révisions du manuscrit de l’AR6N3 (Crok M & A May eds., 2023A49 p. 35–37). Cette dissimulation était nécessaire pour ressusciter (p. 37–39) le terrifiant graphique en crosse de hockeyN18 ! Patrice Poyet écrit à ce sujet (2022A221 p. 143) :

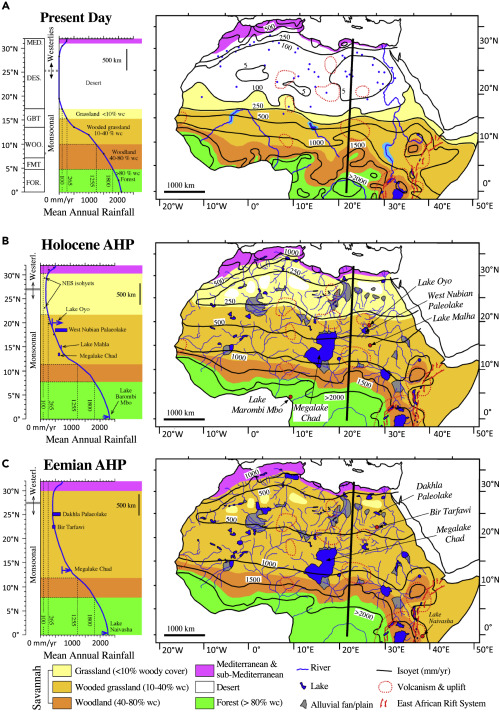

Il convient de noter que l’étude de Huang et al. (2008A119), basée sur des centaines de forages réalisés sur tous les continents (à l’exception de l’Antarctique), qui comptent parmi les moyens les plus fiables d’établir des paléo-températures reconstituées, est en accord avec Christiansen et Ljungqvist (2011A35) et fournit des preuves solides d’une différence de température de 1.0 à 1.5 K entre la période de réchauffement médiéval (MWP) et le petit âge glaciaire (LIA), conformément à Mayewski et al. (1993A174). Il s’agit d’un sujet controversé depuis la reconstruction erronée de la « crosse de hockey » et l’utilisation trompeuse massive qui en est faite par le GIEC depuis des années. En outre, comme l’ont démontré deMenocal et al. (2000A56), le LIA n’est pas un événement régional limité à l’hémisphère nord, puisque « les SST [températures de surface maritimes] subtropicales ont été réduites de 3 à 4°C. Ces événements étaient synchrones avec les changements holocènes des SST de l’Atlantique Nord subpolaire, documentant un lien fort et en phase entre les variations à l’échelle millénaire du climat des hautes et basses latitudes au cours de l’Holocène. »

⇪ Précision des mesures

Elle est rarement discutée sur les plateaux des médias, en dépit des fortes marges d’incertitudes affichées sur les graphiques des météorologues. Le public a tendance à croire que les mesures par satellite de températures de la surface terrestre sont les plus précises. Or il n’en est rien (SCM, 2015A239 p. 9) :

La température ne peut pas être mesurée directement par les satellites. Dans le cas d’un satellite géostationnaire et d’un temps dégagé, la température est obtenue par application de la loi de Planck, qui lie le rayonnement d’un corps noir (en surface — terre et océans) à la température.

Pour déterminer la température en altitude, les satellites à défilement (en orbite plus basse) utilisent la bande d’absorption du gaz carbonique, ou celle de l’oxygène dans le cas d’un temps nuageux. Dans les deux cas, il s’agit de mesures indirectes.

Les mesures par satellites sont imprécises : des paramètres comme la pression ou la vitesse des vents sont difficiles à estimer par satellite, et l’interaction des nuages avec le rayonnement est encore mal comprise. Les radars infrarouges détectent les nuages les plus élevés, mais pas ceux situés en-dessous. Les capteurs micro-ondes voient à travers les nuages, mais évaluent mal les distances.

Ainsi, les mesures par satellites ne sont fiables qu’en temps dégagé, et la température ainsi estimée doit prendre en compte les incertitudes liées aux autres paramètres, qui sont mal évalués.

Il est certes discutable de citer un document datant de 2015, sachant que les données et les connaissances ont évolué. Mais la qualité pédagogique de ce texte de la Société de Calcul Mathématique m’oblige à le faire, en attendant une mise à jour de son contenu et de ses arguments.

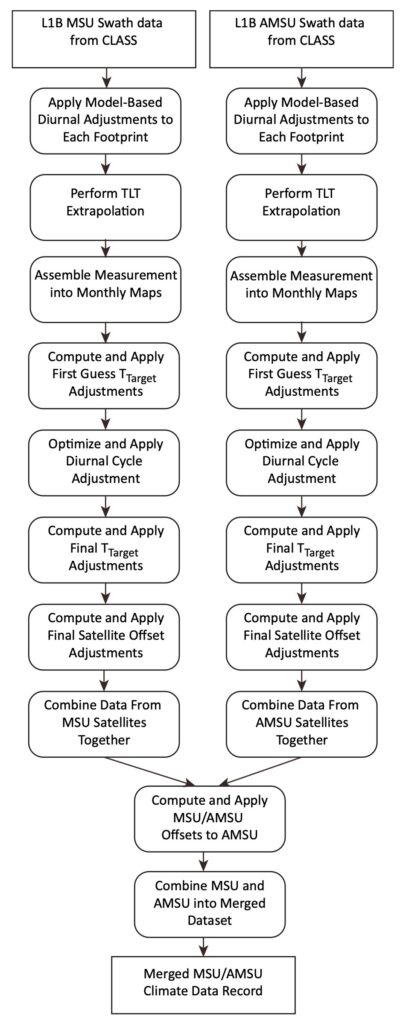

Les données satellitaires font donc l’objet d’ajustements. Patrice Poyet écrit (2022A221 p. 389) :

Par exemple, les données de température (T) sur le graphique de la figure 45 [Poyet P, 2022A221 p. 118] ont été révisées par Mears et Wentz (2017A181) à la suite d’un nombre déconcertant d’opérations, comme le montre la figure 1, p. 7697 de leur article [voir ci-contre]. Après une augmentation de 30 % des ajustements à la hausse, le dernier paragraphe de leur article fournit une longue liste d’excuses pour les futurs ajustements à la hausse. Avec chaque étude, la liste des excuses pour procéder à de nouveaux ajustements à la hausse ne cesse de s’allonger. Et par pure coïncidence, il se trouve que tous les ajustements sont à la hausse. Cela clôture dix années de recherche financée par le contribuable, dont le seul but est de trouver des excuses qui paraissent légitimes, pour procéder à des ajustements à la hausse des données de température satellitaires afin de les rendre compatibles avec la théorie du réchauffement climatique causé par l’Homme.

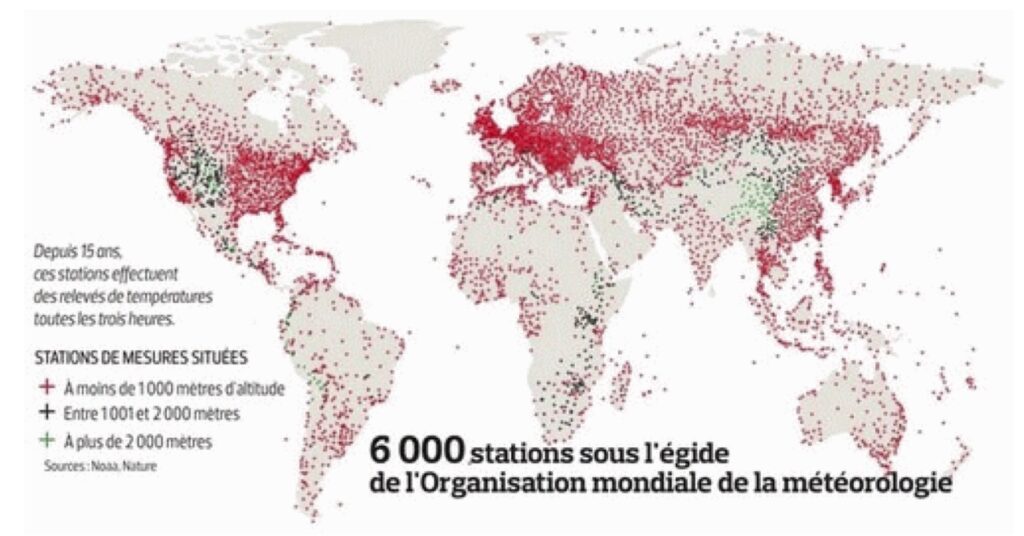

En mer, les bouées météorologiques les plus utilisées (depuis 1970) étaient dérivantes et transmettaient leurs mesures par radio. Elles suivaient les courants marins et ne mesuraient donc jamais deux fois la température en un même point (SCM, 2015A239 p. 9). D’autres bouées ont été fixées par une ancre au fond de l’océan, mesurant la température à une profondeur. de 3 mètres, et permettent d’étalonner et valider les données satellitaires. En raison de leur coût, ces dernières ne sont pas réparties sur un réseau mondial — voir figure 4 (SCM, 2015A239 p. 14).

Les navires de recherche ont également été utilisés pour des mesures de températures, toutefois avec des erreurs de l’ordre de 0.6 degrés, du fait que le capteur était situé à proximité de la salle des machines (SCM, 2015A239 p. 10).

À partir de 1990, la NOAA a introduit un ajustement appliqué aux données des bouées, ajoutant environ +0.12°C aux relevés des bouées lors de la construction de la série ERSSTv4. John R Christy commente (2016A37 p. 7, 8) :

En 1980, seuls 10 % environ des rapports de données provenaient de bouées, alors qu’en 2000, 90 % environ étaient des données de bouées. Ainsi, étant donné que l’influence des données des bouées s’est considérablement accrue au fil du temps, le simple ajout d’un biais à toutes les bouées depuis le début a créé une tendance au réchauffement à mesure qu’elles devenaient la principale source d’information. […]

La NOAA a utilisé une curieuse variable de référence pour étalonner les températures de l’eau mesurées à partir des prises d’eau des navires : la température de l’air marin nocturne (NMAT). Cette curiosité s’explique par le fait que des ajustements considérables sont nécessaires pour les NMAT elles-mêmes, c’est-à-dire des corrections pour la hauteur du pont du navire, etc. Quoi qu’il en soit, les données des bouées ont ensuite été ajustées pour correspondre aux données des navires. Il semble donc que le processus d’ajustement fondamental dépende des NMAT pour ajuster les données des navires afin d’ajuster ensuite les données des bouées.

Une discussion des données de températures océaniques dans le rapport AR6N3 du GIEC (2021) est présentée dans l’article The Frozen Climate Views of the IPCC (Crok M & A May eds., 2023A49 p. 47–49).

Les stations de mesure de la température terrestre sont très irrégulièrement réparties sur le globe. De plus, la NOAA n’utilisait (en 2015) qu’environ un quart des 6000 stations, ce qui rendait encore plus problématique le sous-échantillonnage. À cela s’ajoute le fait que les stations de météo sont de plus en plus souvent situées en zone urbaine, ou près des aéroports, ce qui donne des mesures nettement plus élevées que celles autrefois prélevées dans des zones rurales (Gervais F, 2022A94 p. 67 ; Soon W et al., 2023A267 ; Durkin M, 2024A68 15:22). Ce décalage rend problématique la construction de séries temporelles cohérentes.

Patrice Poyet écrit (2022A221 p. 388) :

Spencer (2016A269) a calculé l’effet moyen de l’Îlot de chaleur urbain (ICUN24) dans les données météorologiques quotidiennes de surface qu’il a calculées à partir des stations météorologiques du monde entier au cours de l’année 2000, sur la base des différences de température quotidiennes entre les stations de température voisines, et en déduit que « comme on peut le voir, même à des densités de population aussi faibles que 10 personnes par kilomètre carré, il y a un réchauffement moyen de 0,6 C (1° F), qui est presque aussi important que le signal de réchauffement global au cours du siècle dernier » et peut aller jusqu’à 2.2°C pour des densités de population allant jusqu’à 7000 personnes par km2.

Roy W Spencer ajoute (2016A269 p. 10) :

Dans le cas des mesures effectuées à l’aide de thermomètres, ces changements n’ont pas eu d’incidence sur les prévisions météorologiques, car ils sont minimes (généralement un degré ou moins) par rapport à l’ampleur des changements météorologiques quotidiens. En revanche, ils sont conséquents et préjudiciables pour la surveillance de la température à long terme.

Mototaka Nakamura écrit (2018A199 p. 14, cité par Jean-Claude Pont, 2020A218) :

Pour les périodes antérieures les données de température recueillies ne valent que pour de très petites surfaces (par rapport à la surface totale de la Terre) et présentent donc un biais spatial important. Nous ne disposons pas d’une quantité suffisante de données pour calculer la tendance de la température moyenne globale de surface pour la période présatellite. En réalité, ce biais spatial important fait planer une grande incertitude sur la signification (ou l’absence de signification) de la « tendance de la température moyenne globale de surface » avant 1980.

Les méthodes de calcul des moyennes sont expliquées en détail sur le document de la SCM (2015A239 p. 19–23). La moyenne arithmétique, la plus souvent utilisée, n’aurait aucun sens pour la Terre entière, du fait de l’inégalité de répartition des capteurs. Elle est donc réservée à des territoires homogènes comme les États-Unis.

Des corrections de températures ont été effectuées sur des données anciennes, comme celles induites en 2001 par les changements des analyses du GISS (Goddard Institute for Space Studies) et du USHCN (United States Historical Climatology Network). Les mathématiciens protestent (SCM, 2015A239 p. 27, 29) :

Notons encore une fois qu’apporter des corrections à une série de données n’est légitime que si l’on apporte ces corrections à toutes les données ; si on ne le fait qu’à partir d’une certaine date, cela fausse les comparaisons. […]

L’ensemble de l’information relative aux températures mondiales est entièrement dépourvu de valeur scientifique, et ne devrait servir de base à aucune décision politique. On constate, de manière parfaitement claire, que :

• Les capteurs de température sont en nombre beaucoup trop faible pour donner une idée de la température du globe ;

• On ne sait pas, par principe, ce qu’une telle température pourrait signifier. On ne parvient pas à lui donner un sens physique précis ;

• On constate de nombreuses dissimulations et manipulations dans les données ; il y a une volonté affichée de passer sous silence ce qui pourrait passer pour rassurant, et de mettre en évidence ce qui est présenté comme inquiétant ;

• Malgré cela, l’utilisation la plus directe des chiffres disponibles ne montre pas de vraie tendance au réchauffement !

Dans la pratique, ce ne sont pas des « températures » qui sont moyennées, mais les « anomalies de températures » (Poyet P, 2022A221 p. 385) :

La première chose à comprendre est qu’il ne s’agit pas de températures. Comme l’explique Hausfather (2014A110) : « La façon dont le NCDC, le GISS, Hadley, calculent les soi-disant températures consiste à prendre les données des stations, à les traduire en anomalies en soustrayant la moyenne à long terme pour chaque mois de chaque station (par exemple la moyenne 1961–1990), à assigner chaque station à une cellule de la grille, à faire la moyenne des anomalies de toutes les stations dans chaque cellule de la grille pour chaque mois, et à faire la moyenne de toutes les cellules de la grille chaque mois, pondérée par leur superficie respective. » Les détails diffèrent légèrement d’un groupe à l’autre, mais c’est ainsi qu’ils produisent des données, appelées anomalies et présentées sous forme de températures. Non seulement cette méthode “Gridded Anomalies” refroidit le passé et augmente la tendance, et toutes les personnes honnêtes impliquées dans un tel processus l’admettront, mais elle conduit également à remettre en question l’intégrité, l’homogénéité et la stabilité à long terme du processus, étant donné que de nombreux changements se produisent au fil du temps, comme nous le verrons. […]

[…] les changements apportés au GHCN [Global Historical Climatology Network] au fil du temps et les méthodologies utilisées introduisent certains biais qui sont encore aggravés par le fait que le réseau mondial d’observation du NCDC, le cœur et l’âme de la mesure des conditions météorologiques de surface, est confronté à de sérieux défis. L’urbanisation a placé de nombreux sites dans des endroits inappropriés, sur de l’asphalte noir et chaud, à côté de barils d’ordures ménagères, à côté de conduits d’évacuation de la chaleur, et même attachés à des cheminées chaudes et au-dessus de grils extérieurs ! Les données et l’approche adoptées par de nombreux alarmistes du réchauffement climatique sont gravement erronées. Si les données mondiales étaient correctement ajustées pour tenir compte de l’urbanisation et de l’emplacement des stations, et si les questions liées aux changements d’utilisation des sols étaient abordées, il en ressortirait un schéma cyclique de hausses et de baisses, avec une tendance de fond beaucoup moins marquée. […]

Ces séries temporelles sont construites par certains processus — et non simplement mesurées — et […] leur qualité dépend de la confiance que l’on place en elles et dans les processus qui les ont générées.

Une discussion des données de températures de l’air en surface (GSAT) — incluant la surface des océans — dans le rapport AR6N3 du GIEC (2021) est présentée dans l’article The Frozen Climate Views of the IPCC (Crok M & A May eds., 2023A49 p. 50–52).

Le site UAH Global Temperature ReportN25 de Roy Spencer fournit tous les mois une mise à jour des relevés satellitaires de l’anomalie de température (par rapport à la moyenne entre 1991 et 2020).

⇪ Artéfacts, erreurs, fraudes ?

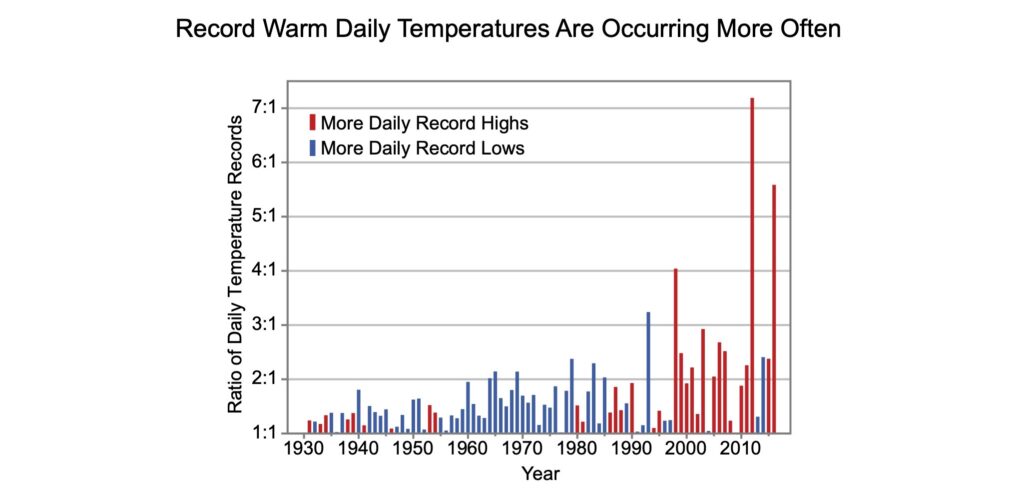

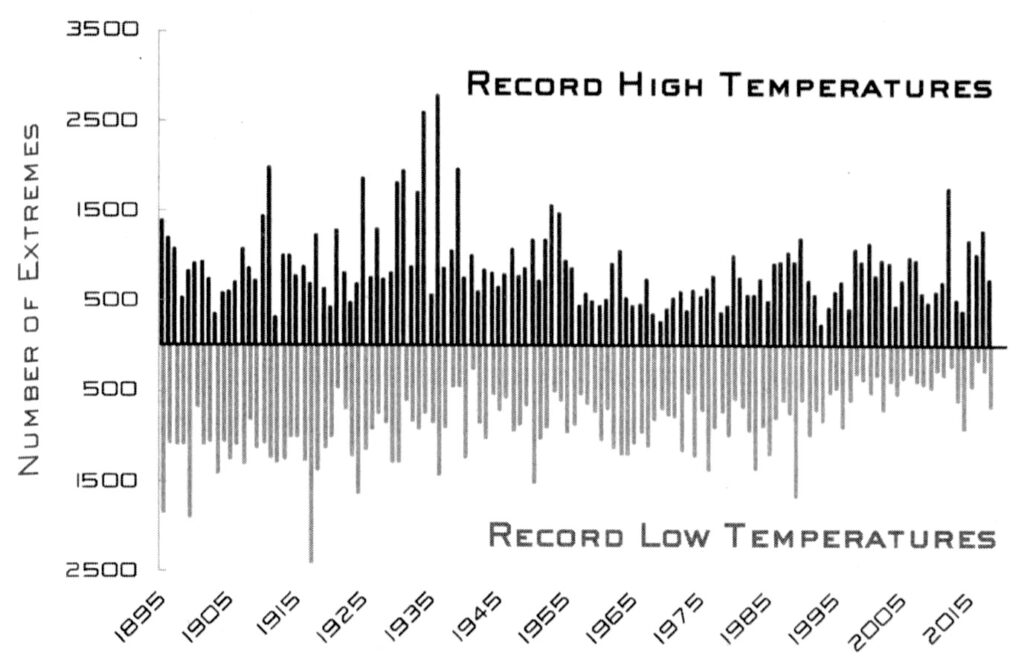

Steven E Koonin a montré (2021A135 p. 100–110) comment le Climate Science Special Report (CSSR), aux USA, affichait les données de températures extrêmes sous un format conciliable avec une conclusion alarmiste (CSSR, 2017N26 p. 19) :

Les températures extrêmes ont connu des changements marqués dans l’ensemble des États-Unis continentaux. Le nombre de records de températures élevées établis au cours des deux dernières décennies dépasse de loin celui des records de températures basses.

La figure suivante sert de justificatif :

Steven Koonin commente (2021A135 p. 102) :

J’ai été troublé par une incohérence apparente entre ce graphique et d’autres, plus bas dans le rapport, en particulier [la figure 6.3]. Elle montre que la température moyenne la plus froide de chaque année a clairement augmenté depuis 1900, alors que la température moyenne la plus chaude n’a pratiquement pas changé au cours des soixante dernières années, étant à peu près la même aujourd’hui qu’en 1900.

[…] il me semblait possible que le rapport entre les records de chaleur et les records de froid illustré par [la figure 6.5] augmente, non pas parce que les records de chaleur deviennent plus fréquents, mais parce que, à mesure que les températures les plus froides se réchauffent, le dénominateur du rapport (nombre de records quotidiens de froid) diminue, tandis que son numérateur (nombre de records quotidiens de chaleur) n’a pratiquement pas changé au cours des dernières décennies.

Koonin explique ensuite (2021A135 p. 103–105) que les records de températures comptabilisés par le CSSR sont des running records (records en continu), autrement dit lorsque la température maximale d’un jour de l’année, pour une station météo, excède celles de toutes les années précédentes. Pour la période étudiée (1930–2017), le nombre de running records était logiquement au plus haut les premières années — démarrant à 365 la première année — puis il diminuait les années suivantes pour atteindre quelques unités au final. Au début de la période, le rapport entre maxima et minima était proche de 1, puis il prenait une valeur de plus en plus incertaine à mesure que le numérateur et le dénominateur diminuaient. C’est pour ces raisons (un simple artéfact mathématique) que les hauteurs des barres de la figure 6.5 apparaissent, au cours du temps, de plus en plus chaotiques — et dénuées de signification. Et non en raison d’un sous-entendu « dérèglement du climat ». Steven Koonin ajoute (2021A135 p. 106) :

Ayant compris que la présentation par le CSSR des températures quotidiennes enregistrées aux États-Unis était très trompeuse, j’ai naturellement voulu savoir ce qu’une analyse correcte — utilisant des records absolus — montrerait. J’ai également voulu savoir ce qu’il en était des températures extrêmes avant 1930…

L’analyse a donc été refaite par le professeur John Christy, de l’Université de l’Alabama, avec le résultat suivant (Koonin SE, 2021A135 p. 107) :

Présentées ainsi, les données sont nettement moins inquiétantes… Steven Koonin ajoute (2021A135 p. 106–110) :

Les records de température montrent clairement que les années 1930 ont été chaudes, mais il n’y a pas de tendance significative sur les 120 années d’observation, ni même depuis 1980, lorsque l’influence humaine sur le climat s’est fortement accrue. En revanche, le nombre de records absolus quotidiens de froid diminue sur plus d’un siècle, cette tendance s’accélérant après 1985. Ces deux graphiques montrent une chose qui va totalement à l’encontre de la perception commune, à savoir que les températures extrêmes dans la zone continentale des États-Unis sont devenues moins fréquentes et un peu plus douces depuis la fin du 19e siècle.

Malgré cela, le résumé de la CSSR met en exergue le graphique de rapports erronés [figure 6.5] avec la légende : « Les records de chaleur journalière sont plus fréquents. » […]

Voilà donc les raisons pour lesquelles j’ai une “Very High Confidence” (confiance très élevée) à identifier et corriger une fausse représentation de la science climatique dans un rapport officiel du gouvernement. Il ne s’agit pas d’un pinaillage, c’est vraiment important. La notion erronée d’une augmentation de la fréquence des records de température aux États-Unis est susceptible de se répercuter dans les rapports d’évaluation ultérieurs, qui citent immanquablement les rapports précédents. […] Il en est de même pour les représentations médiatiques de la science du climat, qui donnent voix à de telles « conclusions » trompeuses. […]

Il se trouve que les preuves d’une augmentation des températures les plus froides sont parfaitement cohérentes avec un réchauffement du globe — mais pas une « planète en feu » qui donne à voir des graphiques d’explosion des températures.

Steven Koonin parle ici de « réchauffement du globe ». Certes, son analyse des données s’écarte du discours d’urgence climatique, mais dans son ouvrage (2021A135 ; version française 2022A136), il fait l’économie d’un examen méthodique du lien de causalité affirmé entre ce réchauffement et la production humaine de gaz à effet de serre. Est-ce par prudence ?

La deuxième partie de son livre (p. 207–255) désamorce les critiques, étant consacrée à des « réponses » dans l’air du temps : diminuer les productions de CO2, de méthane et de CFC, développer les technologies de production d’énergie « décarbonée », les petites centrales nucléaires, la fusion… ainsi que s’adapter au changement climatique et lutter directement contre le réchauffement par des techniques de géo-ingénierie. Il écrit (p. 249) :

Le climat est en train de changer, les humains y jouent un rôle, et pourtant notre besoin global d’énergie augmente en même temps ; nous devons prendre conscience de ce que cela pourrait impliquer dans l’avenir.

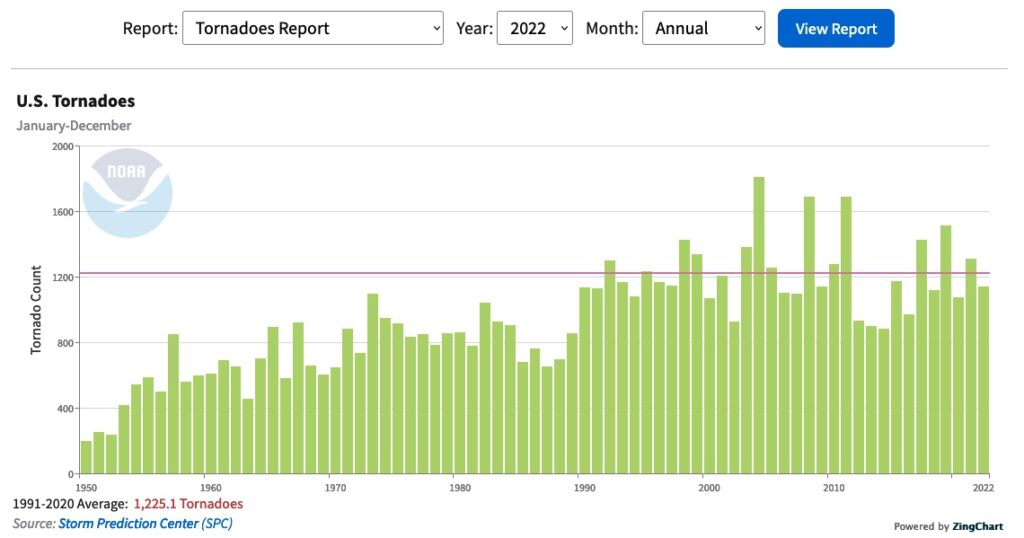

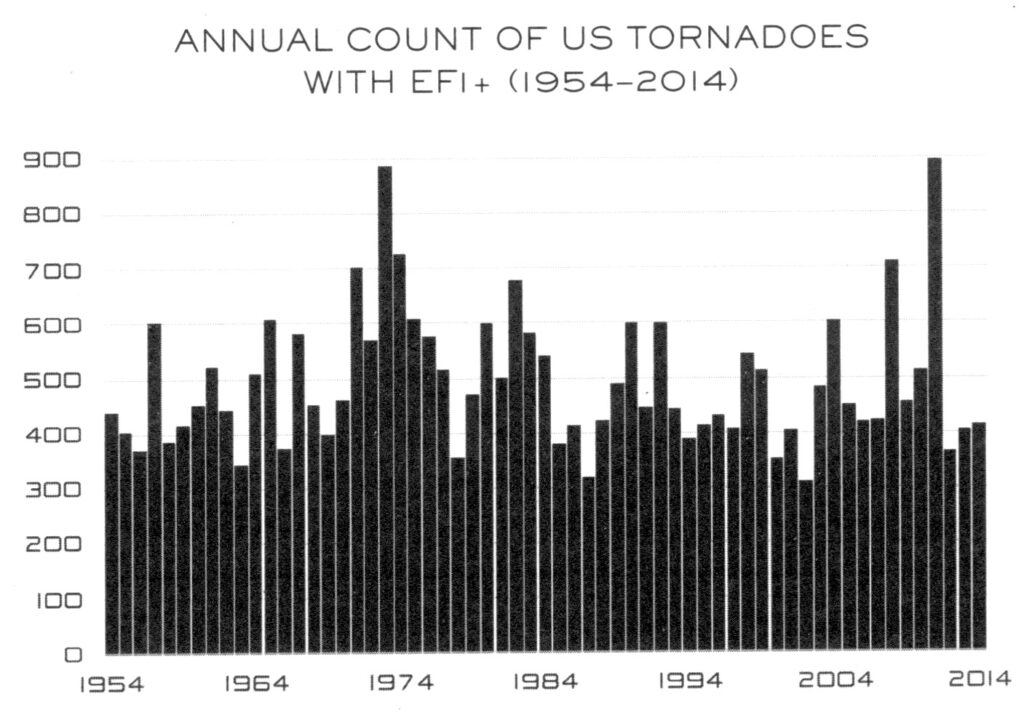

Un autre exemple d’artéfact signalé par Koonin (2021A135 p. 121–126) est le décompte des tornades aux USA. Il apparaît comme croissant sur le site du NCEI (2022N27), laissant supposer que cette augmentation du nombre de tornades serait un effet du réchauffement climatique :

Toutefois, Steven Koonin précise (2021A135 p. 123) :

La violence des tornades est mesurée selon l’échelle Fujita améliorée […] Les catégories de violence vont de EF0, pour des tempêtes très faibles, à EF5, pour des tempêtes dont les vents dépassent les 260 mph [420 km/h]. Aujourd’hui, aux États-Unis, 60 % des tornades enregistrées sont de catégorie EF0, alors qu’en 1950, ces tempêtes ne représentaient qu’environ 20 % du total enregistré. Cela suggère que l’augmentation du nombre de tornades enregistrées est due à la prise en compte d’un plus grand nombre de tempêtes faibles au cours des dernières décennies, ce qui, selon la NOAA, est effectivement le cas.

Nous pouvons corriger le biais d’observation ancien qui empêche de recenser les tempêtes faibles en ne prenant en compte que celles de catégories EF1 et plus — les plus susceptibles de causer des destructions.

Le graphe obtenu sur cette base ne montre aucune augmentation du nombre de tornades dans la période 1954–2014 (2021A135 p. 124) :

Un autre graphe (Koonin SE, 2021A135 p. 124) montre que le nombre de tornades de catégorie égale ou supérieure à EF3 a diminué pendant la même période, alors que l’influence humaine sur le climat allait croissante.

Il est regrettable que dans le film Climate : The Cold Truth (Durkin M, 2024A68 40:23) on affirme directement que « les ouragans ne sont pas plus fréquents », alors que les statistiques en affichent un nombre croissant. Il aurait fallu préciser que c’est la prise en compte de leur intensité qui a montré que cette « croissance » était une fiction. Exemple typique d’un argument que des climato-alarmistes (en partie avertis) soulèveront pour accuser le film d’être construit sur des données falsifiées !

Le vice-président du groupe scientifique du GIEC, Jean Jouzel, déclarait dans son intervention « Le réchauffement est sans équivoque » en 2011 (Ferry L ed., 2011A79 p. 34, 35–36) :

[…] si vous considérez la séquence 2003–2010, elle marque un plateau par rapport à la tendance au réchauffement qui caractérisait les années précédentes. […]

J’estime pour ma part que pour que la conclusion du GIEC soit remise en cause, il faudrait que le « plateau » dont nous venons de parler dure une bonne vingtaine d’années, soit encore dix à quinze ans, ce qui selon moi ne se produira pas.

Source : site La question climatique

Alors que le « plateau » s’était maintenu (depuis 1995), Jouzel annonce triomphalement (Kokabi AR, 2023A132) :

Le climatoscepticisme a muté, parce qu’il était dos au mur. Plus personne ne peut décemment dire que « le Giec exagère », et même le député RN Thomas Ménagé est revenu sur sa déclaration. On les entend moins sur le déni de la réalité scientifique du changement climatique ou de la responsabilité humaine, où ils ont perdu la bataille.

La posture « droit dans ses bottes » est vitale pour un Jean Jouzel bénéficiaire de la médaille d’or du CNRS, en 2002, « pour avoir fait la preuve de l’influence humaine sur le climat ». Comme l’a dit Claude Allègre — lui aussi médaille d’or du CNRS (2010A9 p. 63) : « Jouzel se croit donc lié à la théorie dominante, et il la défendra désormais contre vents et marées. »

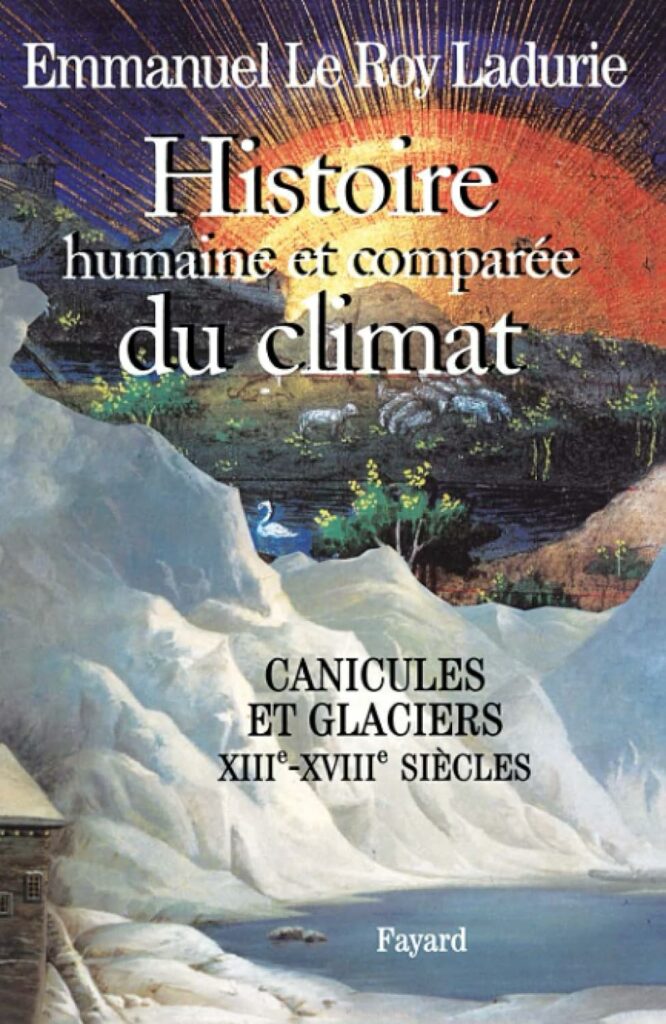

⇪ Fiabilité des modèles prédictifs

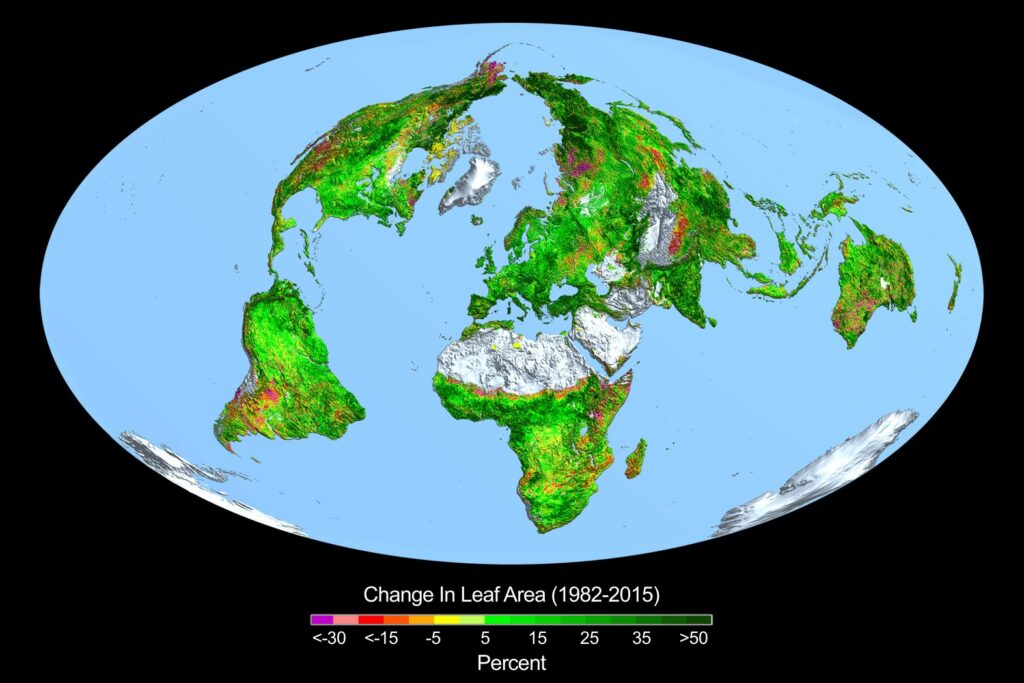

Parler de « dérèglement » du climat présuppose qu’il ait pu exister, dans un Eden pré-industriel, une régularité des événements météorologiques. La lecture de l’Histoire humaine et comparée du climat (Le Roy Ladurie E, 2004A147) permet de prendre conscience de l’extrême variabilité du climat, même à brève échéance. Par exemple, en France, l’incidence (apériodique) d’étés caniculaires, tantôt trop secs tantôt « pourris », au cours d’une période de quelques siècles — le petit âge glaciaire — résumée comme « froide ». Jacques-Marie Moranne écrit (2024bA185 p. 134) :

[…] implicitement, le GIEC considère (arbitrairement) que les variations « naturelles » sont toujours courtes et faibles alors que les variations liées à l’homme sont (les seules) lourdes et longues : il est vrai que cet arbitraire est déjà inclus dans la charte du GIEC qui pose comme principe que les changements climatiques sont d’origine humaine.

Les événements météorologiques sont en fait le produit de l’évolution de systèmes dynamiques complexes non linéaires, théorisés en 1963 par le mathématicien (et météorologue) Edward Lorenz (Masson H, 2019A169).

Les modèles mathématiques servant à simuler de tels systèmes, dans l’espoir de prédire certains aspects de leur évolution, sont sensibles à d’infimes variations des paramètres à l’état initial. Une telle sensibilité — signature d’un comportement chaotique — était déjà visible sur le premier modèle de Lorenz qui dépendait seulement de trois variables.

Imaginé aussi par Lorenz, le moulin à eau chaotique est une illustration graphique de l’extrême sensibilité aux conditions initiales d’un système dynamique complexe non-linéaire. Alors que son mouvement est parfaitement déterministe — régi par les lois de la physique appliquées à un mécanisme absolument régulier — il apparaît imprédictible aux yeux d’un physicien qui n’est pas en mesure de mesurer chaque paramètre, ni de calculer ses variations, avec une précision absolue. Étienne Ghys (2009A104) a illustré sa « dépendance sensible aux conditions initiales » en programmant une simulation de deux moulins en tous points identiques et recevant le même débit d’eau, mais dont la roue, au départ, est tournée de 2 degrés sur celui de gauche, contre 1.9996 degrés sur celui de droite. Cette infime différence (de 2 pour mille) sur un seul paramètre suffit à faire diverger les trajectoires des moulins malgré leur apparente synchronisation juste après leur démarrage.

Si les modèles de systèmes dynamiques complexes non-linéaires ne permettent pas de faire des prédictions à long terme — la thèse avancée par Edward Lorenz pour ce qui concerne la météorologie — ils peuvent afficher certaines « régularités ». Par exemple, ici, la distribution statistique de la vitesse de rotation est indépendante de la position initiale de la roue (Ghys E, 2009A104). Mais cela ne vaut ici que pour une variable — dont l’étude statistique n’est pas forcément intéressante — et de manière générale que lorsqu’un seul paramètre initial a été modifié. L’invariabilité de la distribution statistique des vitesses de rotation par rapport à la position angulaire initiale est même un résultat trivial…

Un autre exemple de système chaotique (plus facile à réaliser) est le pendule à deux branches — voir vidéo et image ci-contre.

Peut-on observer une évolution régulière de variables (jugées pertinentes) avec des conditions initiales qui dépendent d’une multitude de paramètres ? C’est le cas des « modèles de climat » dont les paramètres se comptent par centaines ou par milliers.

La prévision d’événements climatiques est aujourd’hui possible sur une durée d’une quinzaine de jours — la « frontière du chaos » — au prix du traitement d’une grande masse de données : c’est le travail des météorologues. Les prédictions saisonnières (à six mois), surtout dans l’hémisphère nord, restent par contre très incertaines (Poyet P, 2022A221 p. 347–349). En Chine, des prédictions saisonnières de précipitations sont proposées à partir de l’analyse statistique de variations de la température du sol à 3.20 mètres de profondeur, elles-mêmes corrélées aux secousses sismiques (Liu Y & R Avissar, 1999A155 ; Guo WD et al., 2013A103 ; Zhou Y et al., 2023A321).

Dans ces conditions, comment peut-on envisager sérieusement — à partir du même bagage théorique — une modélisation réaliste couvrant plusieurs décennies ?

Sans surprise, les prévisions des modèles de climat s’écartent des observations chaque fois que le calcul est lancé à partir d’une date antérieure pour vérifier la qualité prédictive du modèle. Certes, on peut bricoler jusqu’à ce que cette « prévision rétrospective » (sic) reproduise au mieux les données réelles, mais aucun « réglage » (tuning ou fudge) ayant satisfait cette condition ne garantit que l’extrapolation aux années futures restera réaliste.

Pratiquement tous les premiers modèles ont été calibrés de façon à reproduire les températures de surface moyenne observées au XXe siècle (Voosen P, 2016A305). Judith Curry ajoute (2024A52 p. 138 ; 2023A51 p. 82) :

En outre, régler les modèles climatiques sur les observations réalisées sur la période 1975–2000, c’est les régler sur une phase de réchauffement de la variabilité naturelle interne, et cela se traduit par une sensibilité exagérée des modèles au CO2, puisque le réchauffement dû à la variabilité naturelle est [alors] étalonné sur le réchauffement dû au CO2.

Dans leur article Are general circulation models obsolete ? (les modèles de circulation généraleN12 [GCM] sont-ils obsolètes ?), Venkatramani Balaji et ses collègues écrivent (2022A13) :

Une deuxième critique à l’égard des GCM porte sur la question de la « mise au point » ou de l’étalonnage des modèles climatiques. Comme indiqué ci-dessus, la physique non résolue (U + P) est représentée à l’aide d’équations dont les paramètres sont contraints dans une certaine fourchette par les observations ou la théorie. Le système couplé est ensuite soumis à des contraintes globales, telles que le bilan énergétique au sommet de l’atmosphère (Hourdin F et al., 2017A117). Le fait que les modèles soient réglés pour reproduire certaines caractéristiques de la planète observée est considéré par certains comme rendant les résultats suspects.

Les auteurs de l’article The Art and Science of Climate Model Tuning (L’art et la science du réglage des modèles climatiques) reconnaissent (Hourdin F et al., 2017A117) :

Les choix et les compromis effectués au cours de l’exercice de réglage peuvent affecter de manière significative les résultats du modèle et influencer les évaluations qui mesurent une distance statistique entre le climat simulé et le climat observé. Bien que le besoin de réglage des paramètres ait été reconnu dans des travaux de modélisation… Il est souvent ignoré lors de l’examen des performances des modèles climatiques… En fait, la stratégie de réglage ne faisait même pas partie de la documentation requise des simulations CMIP phase 5… Pourquoi un tel manque de transparence ? Cela peut être dû au fait que le réglage est souvent considéré comme une partie inévitable mais sale de la modélisation du climat, plus d’ingénierie que de science, un acte de bricolage qui ne mérite pas d’être enregistré dans la littérature scientifique… Le réglage peut en effet être considéré comme un moyen indescriptible de compenser les erreurs de modèle…

Pascal Blamet ajoute (2021A23) :

Ces pratiques traduisent une grande faiblesse face à la complexité du sujet, car les numériciens le savent bien : on peut toujours parvenir à des ajustements numériques, mais si les fonctions ou paramètres ne sont pas représentatifs de la phénoménologie modélisée, les calculs ne valent rien ; de la même façon que les corrélations statistiques sans causalité sont de purs sophismes. […]

Ces points ne sont pas non plus discutés publiquement par la communauté scientifique climatique, pour une raison simple : elle n’est globalement pas compétente en matière de modélisation numérique.

Le mathématicien John Von Neumann disait : « Si vous me laissez quatre paramètres au choix, je peux construire un modèle mathématique qui décrit exactement tout ce qu’un éléphant peut faire. Si vous m’accordez un cinquième paramètre, le modèle que je construis prévoira que l’éléphant peut voler. » (Gerlich G & RD Tscheuschner, 2009A89 p. 352)

Comme le disait un commentateur de la revue Science, cité par Pierre-Gilles de Gennes : « Dans la modélisation du climat, presque tout le monde triche (un peu)… »

Judith Curry écrit (2024A52 p. 152, 181 ; 2023A51 p. 89, 107) :

Les chercheurs reconnaissent la nécessité de réglages du modèle nécessaires pour « prouver » un phénomène décidé à l’avance, comme la sensibilité climatique à l’équilibreN28 (Mauritsen T & Roeckner E, 2020A172 p. 1, 8) :

La capacité d’un modèle climatique à reproduire le réchauffement historique observé est parfois considérée comme une mesure de qualité. Pourtant, pour des raisons pratiques, elle ne peut pas être considérée comme un résultat purement empirique des efforts de modélisation, car le résultat souhaité est connu à l’avance et constitue donc une cible potentielle de réglage. […]

Nous avons documenté la façon dont nous avons réglé le modèle climatique global MPI-ESM 1.2 pour qu’il corresponde à l’enregistrement instrumental du réchauffement ; un effort couronné de succès. Pour respecter le déroulement historique des événements, le choix pratique a été de viser une sensibilité climatique de 3° K en utilisant la rétroaction des nuages, plutôt qu’un réglage du forçage associé aux aérosols.

Il s’agissait ici de rétroactions négatives. Des rétroactions positives sont postulées, au besoin, dans d’autres contextes, voir ci-dessous (Moranne JM, 2024bA185 p. 120-ff).

La modélisation consiste à mettre en équations des modèles du système Terre (Earth System Models, ESM) capables de décrire de manière réaliste les phénomènes atmosphériques récurrents et d’anticiper leur évolution sur de longues périodes. Un des premiers ESM a été proposé par Phillips (1956A215). Les modèles de circulation générale ont vu le jour à la même époque. Le travail des physiciens reposait dur une base conceptuelle simple et solide (Poyet P, 2022A221 p. 331, citant Goosse et al., 2010A100) :

Les équations fondamentales qui régissent l’atmosphère peuvent être formulées comme un ensemble de sept équations à sept inconnues : les trois composantes de la vitesse, la pression, la température, le pourcentage d’humidité et la densité. […]

Malheureusement, ces sept équations ne forment pas un système fermé. Tout d’abord, la force de frottement et le taux de dissipation thermique doivent être spécifiés. Le calcul du taux de dissipation, en particulier, nécessite une analyse détaillée du transfert radiatif dans l’atmosphère, prenant en compte à la fois les ondes longues et les ondes courtes dans les colonnes atmosphériques, ainsi que les transferts de chaleur associés à l’évaporation, à la condensation et à la sublimation. L’influence des nuages sur ces processus est généralement une source d’incertitude considérable.

Et plus loin (Poyet P, 2022 p. 378) :

Coupler de manière convaincante les cases de circulation océan-atmosphère a été, et reste un défi permanent, mais ajouter les composants de glace, l’utilisation des terres, la végétation, les stocks d’eau douce et tous les processus géochimiques requiert beaucoup de foi pour penser que cela nous donnera une idée de la manière dont la planète Terre se comportera réellement. Le passage de l’échelle temporelle de prédiction des systèmes météorologiques, essentiellement une semaine, à un mois ou un peu plus est démontré comme un défi majeur par la prévision d’événements exceptionnels tels que les vagues de chaleur, par exemple (Weisheimer et al., 2011A312 ; Stéfanon, 2012A275).

François Gervais écrit (2022A94 p. 92) :

Le consortium UCAR (University Corporation for Atmospheric Research) regroupe une centaine d’universités et écoles en sciences de l’atmosphère. Ils ont fait « tourner » un même modèle de climat de l’Amérique du Nord sur 50 ans, avec la même évolution de la concentration de CO2, en ne changeant que d’un millième de milliardième les conditions initiales [Kay JE et al., 2015A126]. Le millième de milliardième est suffisant pour provoquer 30 évolutions différentes. Il s’avère qu’il était impossible de prévoir à l’avance lequel des 30 essais se rapprocherait le plus du climat observé, et lequel s’en est éloigné le plus. Cette expérience conduite sur ordinateur illustre à merveille l’extrême sensibilité d’un système chaotique aux conditions initiales, et la vanité d’espérer une quelconque prédiction fiable.

Le troisième rapport (TAR) du GIEC le reconnaissait explicitement : « Dans la modélisation du climat, nous devons reconnaître que nous avons affaire à un système chaotique non linéaire couplé, et donc que la prédiction à long terme des futurs états climatiques n’est pas possible. » Même si l’on moyenne des comportements chaotiques, on obtient un comportement chaotique moyen, pas une meilleure prédiction.

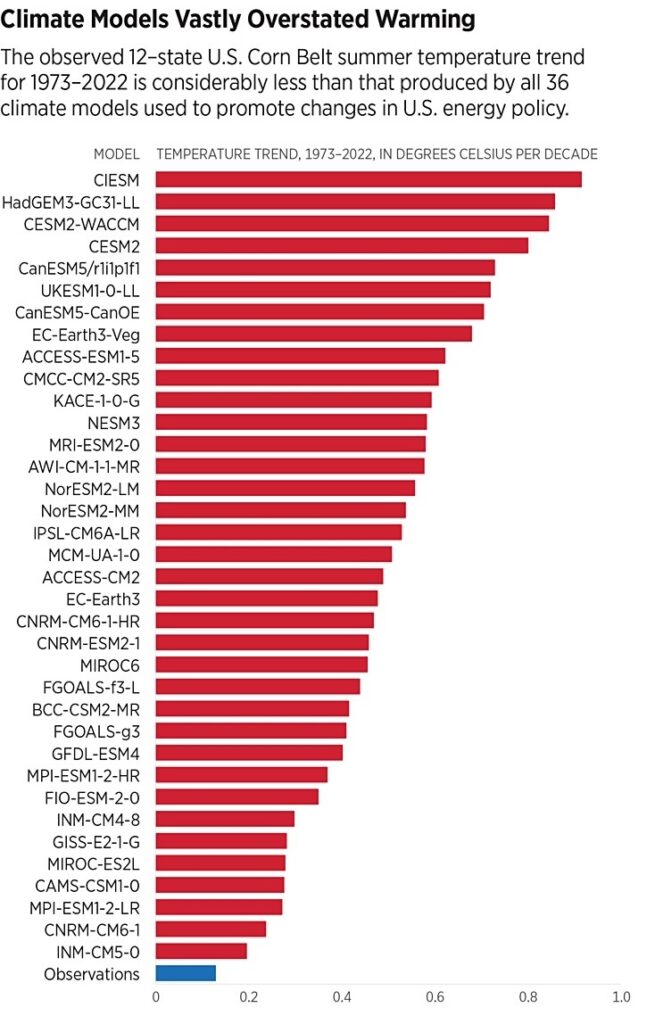

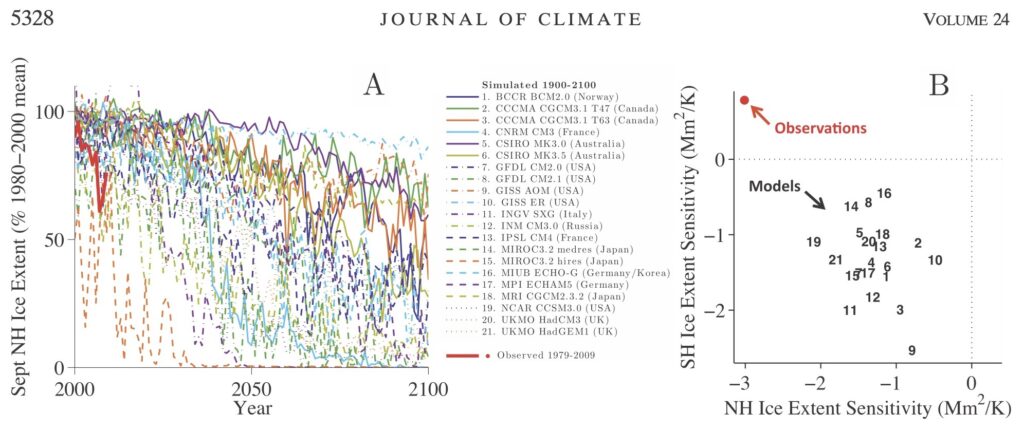

Une présentation pédagogique des modèles prédictifs de climat a été proposée par Steven Koonin (2021A135 p. 77–96) puis Judith Curry (2024A52 p. 129–177 ; 2023A51 p. 77–94). En observant les incertitudes des modèles comparatifs CMIP3 (2007) et CMIP5 (2013), Koonin constate (p. 87) que les plus récents sont entachés de plus d’incertitude que les plus anciens, alors qu’on s’attendait à l’inverse, compte tenu des progrès en termes de modélisation et de collection de données. François Gervais (2022A94 p. 54) confirme cette augmentation de l’incertitude entre les modèles du CMIP5 (2013) et ceux du CMIP6 (2021). Judith Curry écrit (2024A52 p. 118 ; 2023A51 p. 69) :

Mais mieux nous comprenons le problème, plus il acquiert de nouvelles dimensions, accroissant du même coup l’incertitude.

Une importante source d’incertitude en modélisation climatique relève du traitement des nuages, dont les dimensions sont nettement plus petites que la trame servant à partitionner l’atmosphère (Schneider T et al., 2017A256 p. 4) :

Actuellement, nous utilisons des modèles climatiques qui ne sont pas adaptés à cette tâche : leurs modèles atmosphériques ont un espacement de grille horizontal d’environ 50–100 km et un espacement de grille vertical d’environ 200 mètres dans la basse atmosphère. Ceci est beaucoup trop grossier pour résoudre les courants ascendants turbulents de 10 à 100 mètres de large, qui prennent naissance dans la couche limite planétaire et génèrent des nuages bas.

Les physiciens Gerhard Gerlich et Ralph D Tscheuschner ont depuis longtemps souligné radicalement les incohérences de cette modélisation (2009A89 p. 350, 351, 353) :

Les équations de Navier-Stokes sont en quelque sorte le Saint-Graal de la physique théorique, et une discrétisation brute à l’aide de grilles à mailles très larges conduit à des modèles qui n’ont rien à voir avec le problème original et n’ont donc aucune valeur prédictive.

Dans les problèmes impliquant des équations différentielles partielles, les conditions aux limites déterminent les solutions bien plus que les équations différentielles elles-mêmes. L’introduction d’une discrétisation équivaut à l’introduction de conditions aux limites artificielles, une procédure qui est caractérisée par la déclaration de von Storch : « La discrétisation est le modèle. » Dans ce contexte, une déclaration correcte d’un mathématicien ou d’un physicien théorique serait la suivante : « Une discrétisation est un modèle dont les conditions aux limites ne sont pas physiques. » Les discrétisations de problèmes de continuums seront autorisées s’il existe une stratégie permettant de calculer des raffinements progressifs. […] Au mieux, ces modèles informatiques peuvent être considérés comme un jeu heuristique.

En général, il est impossible de dériver des équations différentielles pour les fonctions moyennées et, par conséquent, pour les dynamiques non linéaires moyennées. Il n’y a donc tout simplement pas de fondement physique aux modèles informatiques du climat global, pour lesquels le paradigme du chaos est toujours d’actualité. […]

La climatologie globale moderne a confondu et continue de confondre les faits et la fiction en substituant le concept de scénario à celui de modèle. […] En conclusion, les déclarations sur le réchauffement climatique anthropique induit par le CO2 qui sont déduites des simulations informatiques ne relèvent d’aucune science.

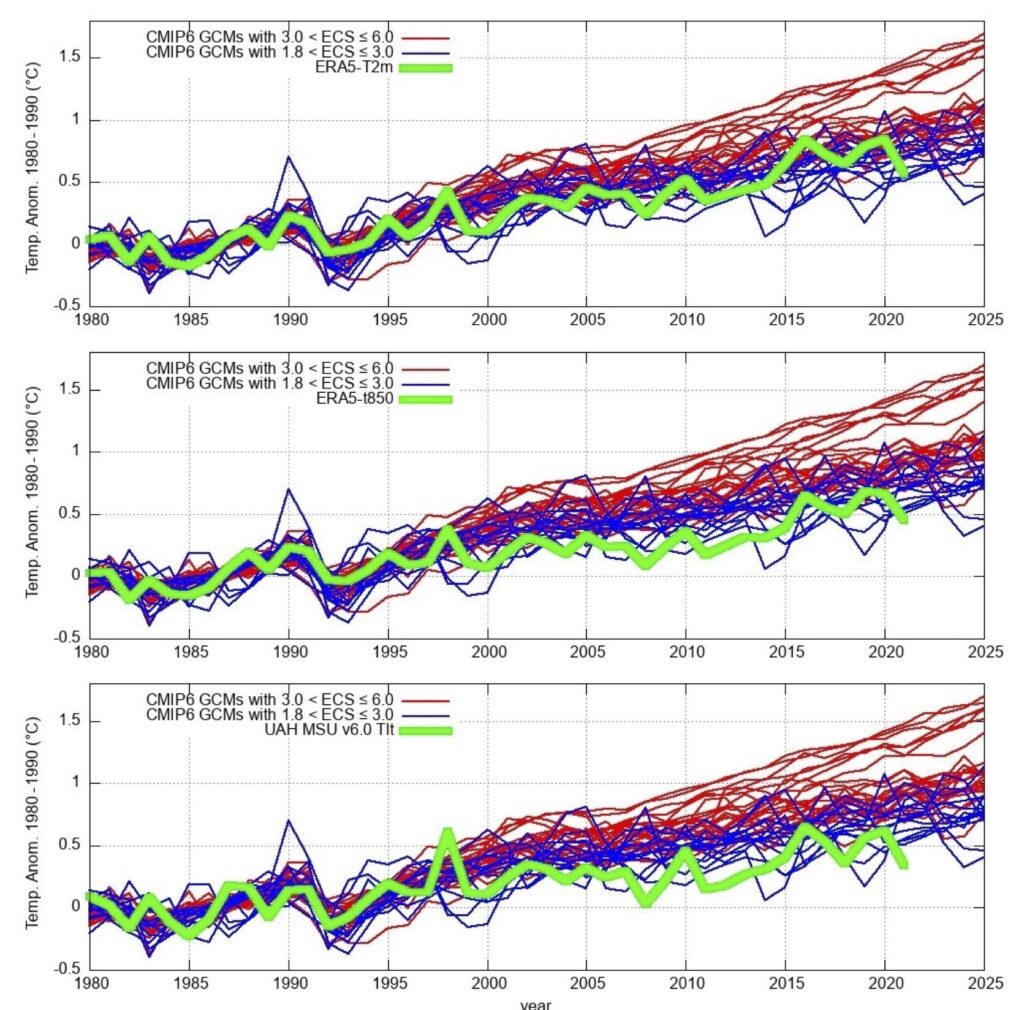

La fiabilité des modèles de climat est étudiée depuis une vingtaine d’années par le World Climate Research Programme (WCRP), à l’origine des Coupled Model Intercomparison Projects (CMIP). Elle a été exposé notamment par Nicola Scafetta (2021cA249). Chaque modèle de circulation généraleN12 (GCM) possède une valeur spécifique de l’Equilibrium Climate Sensitivity (ECS) ou sensibilité climatique à l’équilibreN28. Il s’agit du réchauffement de la surface du globe (à l’équilibre thermique) induit par le doublement de la concentration atmosphérique de CO2 par rapport à la valeur préindustrielle, autrement dit de 280 à 560 ppm.

Le GIEC cite souvent la formule logarithmique empirique de Myhre (1998A192) qui donne le forçage radiatifN5 en fonction de l’évolution relative de concentration du CO2 (Moranne JM, 2024bA185 p. 120-ff) :